A narrativa da IA tem sido dominada principalmente pelo desempenho do modelo nos principais benchmarks do setor. Mas à medida que o campo amadurece e as empresas procuram extrair valor actual dos avanços na IA, vemos pesquisas paralelas em técnicas que ajudam a produzir aplicações de IA.

Na VentureBeat, estamos acompanhando pesquisas de IA que podem ajudar a entender o rumo que a implementação prática da tecnologia está tomando. Estamos ansiosos por avanços que não envolvam apenas a inteligência bruta de um único modelo, mas também a forma como projetamos os sistemas em torno deles. À medida que nos aproximamos de 2026, aqui estão quatro tendências que podem representar o modelo para a próxima geração de aplicações empresariais robustas e escaláveis.

Aprendizagem contínua

A aprendizagem contínua aborda um dos principais desafios dos modelos atuais de IA: ensinar-lhes novas informações e habilidades sem destruir o conhecimento existente (muitas vezes referido como “esquecimento catastrófico”).

Tradicionalmente, existem duas maneiras de resolver isso. Uma delas é treinar novamente o modelo com uma mistura de informações antigas e novas, o que é caro, demorado e extremamente complicado. Isso o torna inacessível para a maioria das empresas que utilizam modelos.

Outra solução alternativa é fornecer aos modelos informações contextualizadas por meio de técnicas como RAG. No entanto, essas técnicas não atualizam o conhecimento interno do modelo, o que pode ser problemático à medida que você se afasta do limite de conhecimento do modelo e os fatos começam a entrar em conflito com o que period verdade no momento do treinamento do modelo. Eles também exigem muita engenharia e são limitados pelas janelas de contexto dos modelos.

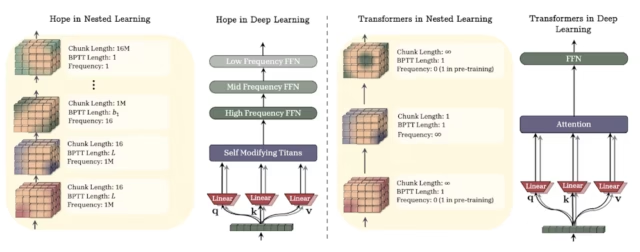

A aprendizagem contínua permite que os modelos atualizem o seu conhecimento interno sem a necessidade de reciclagem. O Google tem trabalhado nisso com vários novos modelos de arquiteturas. Um deles é o Titans, que propõe uma primitiva diferente: um módulo aprendido de memória de longo prazo que permite ao sistema incorporar o contexto histórico no momento da inferência. Intuitivamente, ele transfere parte do “aprendizado” das atualizações de peso offline para um processo de memória on-line, mais próximo de como as equipes já pensam sobre caches, índices e logs.

Nested Studying aborda o mesmo tema de outro ângulo. Ele trata um modelo como um conjunto de problemas de otimização aninhados, cada um com seu próprio fluxo de trabalho interno, e usa esse enquadramento para resolver o esquecimento catastrófico.

Os modelos de linguagem padrão baseados em transformadores possuem camadas densas que armazenam a memória de longo prazo obtida durante o pré-treinamento e camadas de atenção que armazenam o contexto imediato. Nested Studying introduz um “sistema de memória contínua”, onde a memória é vista como um espectro de módulos que são atualizados em diferentes frequências. Isso cria um sistema de memória mais sintonizado com o aprendizado contínuo.

O aprendizado contínuo é complementar ao trabalho realizado para fornecer aos agentes memória de curto prazo por meio da engenharia de contexto. À medida que amadurece, as empresas podem esperar uma geração de modelos que se adaptem a ambientes em mudança, decidindo dinamicamente quais novas informações internalizar e quais preservar na memória de curto prazo.

Modelos mundiais

Os modelos mundiais prometem dar aos sistemas de IA a capacidade de compreender os seus ambientes sem a necessidade de dados rotulados por humanos ou de texto gerado por humanos. Com modelos mundiais, os sistemas de IA podem responder melhor a eventos imprevisíveis e fora de distribuição e tornar-se mais robustos contra a incerteza do mundo actual.

Mais importante ainda, os modelos mundiais abrem caminho para sistemas de IA que podem ir além do texto e resolver tarefas que envolvem ambientes físicos. Os modelos mundiais tentam aprender as regularidades do mundo físico diretamente a partir da observação e da interação.

Existem diferentes abordagens para a criação de modelos mundiais. A DeepMind está construindo o Genie, uma família de modelos generativos ponta a ponta que simulam um ambiente para que um agente possa prever como o ambiente evoluirá e como as ações o alterarão. Ele captura uma imagem ou immediate junto com as ações do usuário e gera a sequência de quadros de vídeo que refletem como o mundo muda. A Genie pode criar ambientes interativos que podem ser usados para diversos fins, incluindo treinamento de robôs e carros autônomos.

Laboratórios Mundiaisuma nova startup fundada pelo pioneiro da IA Fei-Fei Li, adota uma abordagem um pouco diferente. Marble, o primeiro sistema de IA do World Labs, usa IA generativa para criar um modelo 3D a partir de uma imagem ou immediate, que pode então ser usado por um mecanismo físico e 3D para renderizar e simular o ambiente interativo usado para treinar robôs.

Outra abordagem é a Joint Embedding Predictive Structure (JEPA), defendida pelo vencedor do Prêmio Turing e ex-chefe da Meta AI, Yann LeCun. Os modelos JEPA aprendem representações latentes a partir de dados brutos para que o sistema possa antecipar o que vem a seguir sem gerar cada pixel.

Os modelos JEPA são muito mais eficientes do que os modelos generativos, o que os torna adequados para aplicações de IA em tempo actual de ritmo acelerado que precisam ser executadas em dispositivos com recursos limitados. V-JEPA, a versão em vídeo da arquitetura, é pré-treinada em vídeo não rotulado em escala de Web para aprender modelos mundiais por meio da observação. Em seguida, adiciona uma pequena quantidade de dados de interação das trajetórias do robô para apoiar o planejamento. Essa combinação sugere um caminho em que as empresas aproveitam vídeos passivos abundantes (treinamento, inspeção, câmeras de painel, varejo) e adicionam dados de interação limitados e de alto valor onde precisam de controle.

Em novembro, LeCun confirmou que deixará Meta e iniciará uma nova startup de IA que buscará “sistemas que entendam o mundo físico, tenham memória persistente, possam raciocinar e planejar sequências de ação complexas”.

Orquestração

Os LLMs da Frontier continuam a avançar em benchmarks muito desafiadores, muitas vezes superando os especialistas humanos. Mas quando se trata de tarefas do mundo actual e fluxos de trabalho de agentes de várias etapas, até mesmo modelos fortes falham: eles perdem contexto, chamam ferramentas com parâmetros errados e cometem pequenos erros.

A orquestração trata essas falhas como problemas de sistema que podem ser resolvidos com a estrutura e a engenharia corretas. Por exemplo, um roteador escolhe entre um modelo pequeno e rápido, um modelo maior para etapas mais difíceis, recuperação para aterramento e ferramentas determinísticas para ações.

Existem agora várias estruturas que criam camadas de orquestração para melhorar a eficiência e a precisão dos agentes de IA, especialmente ao usar ferramentas externas. O OctoTools de Stanford é uma estrutura de código aberto que pode orquestrar várias ferramentas sem a necessidade de ajustar ou ajustar os modelos. OctoTools usa uma abordagem modular que planeja uma solução, seleciona ferramentas e passa subtarefas para diferentes agentes. OctoTools pode usar qualquer LLM de uso geral como espinha dorsal.

Outra abordagem é treinar um modelo de orquestrador especializado que possa dividir o trabalho entre os diferentes componentes do sistema de IA. Um exemplo é o Orchestrator da Nvidia, um modelo de 8 bilhões de parâmetros que coordena diferentes ferramentas e LLMs para resolver problemas complexos. O Orchestrator foi treinado por meio de uma técnica especial de aprendizado por reforço projetada para orquestração de modelos. Pode dizer quando usar ferramentas, quando delegar tarefas a pequenos modelos especializados e quando usar as capacidades de raciocínio e conhecimento de grandes modelos generalistas.

Uma das características destes e de outros quadros semelhantes é que podem beneficiar de avanços nos modelos subjacentes. Assim, à medida que continuamos a ver avanços nos modelos de fronteira, podemos esperar que as estruturas de orquestração evoluam e ajudem as empresas a construir aplicações de agente robustas e eficientes em termos de recursos.

Refinamento

As técnicas de refinamento transformam “uma resposta” em um processo controlado: propor, criticar, revisar e verificar. Ele enquadra o fluxo de trabalho usando o mesmo modelo para gerar um resultado inicial, produzir suggestions sobre ele e melhorar iterativamente, sem treinamento adicional.

Embora as técnicas de autoaperfeiçoamento já existam há alguns anos, podemos estar em um ponto em que podemos vê-las fornecer uma mudança radical nas aplicações de agente. Isto foi plenamente evidenciado nos resultados do Prémio ARC, que apelidou 2025 como o “Ano do Ciclo de Refinamento” e escreveu: “Do ponto de vista da teoria da informação, refinamento é inteligência”.

ARC testa modelos em complicados quebra-cabeças de raciocínio abstrato. A própria análise da ARC relata que a solução de refinamento mais verificada, construída num modelo de fronteira e desenvolvido por Poetiqatingiu 54% no ARC-AGI-2, vencendo o segundo colocado, Gemini 3 Deep Assume (45%), pela metade do preço.

A solução da Poetiq é um sistema recursivo e de autoaperfeiçoamento que é independente do LLM. Ele foi projetado para aproveitar os recursos de raciocínio e o conhecimento do modelo subjacente para refletir e refinar sua própria solução e invocar ferramentas como interpretadores de código quando necessário.

À medida que os modelos se tornam mais fortes, a adição de camadas de auto-refinamento tornará possível tirar mais proveito deles. A Poetiq já está a trabalhar com parceiros para adaptar o seu meta-sistema para “lidar com problemas complexos do mundo actual que os modelos de fronteira lutam para resolver”.

Como rastrear pesquisas de IA em 2026

Uma maneira prática de ler a pesquisa no próximo ano é observar quais novas técnicas podem ajudar as empresas a migrar aplicações de agente de prova de conceito para sistemas escaláveis.

A aprendizagem contínua muda o rigor em direção à proveniência e retenção da memória. Os modelos mundiais mudam para uma simulação robusta e previsão de eventos do mundo actual. A orquestração direciona-o para um melhor uso dos recursos. O refinamento o leva à reflexão inteligente e à correção de respostas.

Os vencedores não apenas escolherão modelos fortes, mas também construirão o plano de controle que mantém esses modelos corretos, atuais e econômicos.