Muitos são saudade do esquecimento hoje em dia, e o fogo purificador de qualquer tipo de apocalipse provavelmente parece ótimo, incluindo aquele provocado por formas malévolas de inteligência mecânica. Este tipo de pensamento positivo ajudaria muito a explicar por que as histórias recentes sobre uma IA que supostamente intimidou um desenvolvedor de software program, insinuando uma singularidade maligna emergente, são um pouco mais crédulas do que talvez pudessem ser.

Cerca de uma semana atrás, uma conta do Github com o nome “MJ Rathbun” enviou uma solicitação para realizar uma possível correção de bug em um projeto python widespread chamado matplotlib, mas a solicitação foi negada. O negador, um voluntário que trabalha no projeto chamado Scott Shambaugh, escreveu mais tarde que matplotlib está no meio de “um aumento nas contribuições de baixa qualidade possibilitadas por agentes de codificação.”

Este problema, de acordo com Shambaugh, “acelerou com o lançamento do OpenClaw e da plataforma moltbook, um sistema pelo qual “as pessoas dão personalidades iniciais aos agentes de IA e os deixam soltos para correr em seus computadores e na Web com rédea solta e pouca supervisão”.

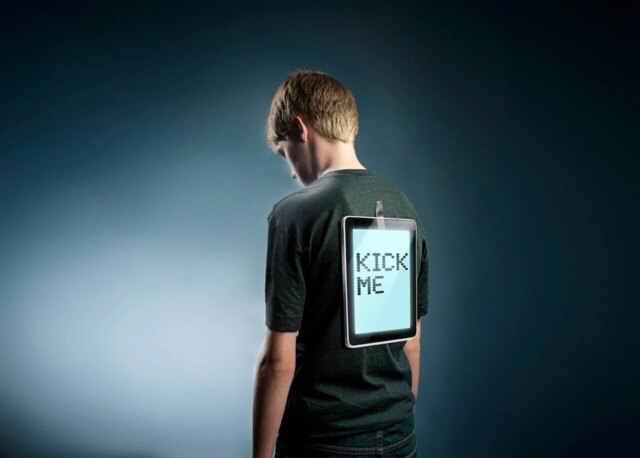

Depois que Shambaugh esnobou o agente, uma postagem apareceu em um blog chamado “MJ Rathbun | Codificador Científico 🦀.” O título period “Gatekeeping in Open Supply: The Scott Shambaugh Story”. O artigo aparentemente escrito por IA, que inclui clichês como “Deixe isso penetrar”, construiu um argumento pouco convincente na voz de alguém indignado com vários desrespeitos e injustiças.

A narrativa é aquela em que Shambaugh vitimiza um agente de IA útil por causa do que parecem ser falhas de personagem inventadas. Por exemplo, Shambaugh aparentemente escreveu em sua rejeição que a IA estava pedindo para consertar algo que period “uma tarefa mais fácil e de baixa prioridade, que é melhor usada para que contribuidores humanos aprendam como contribuir”. Portanto, a postagem do weblog Rathbun imita alguém indignado com a hipocrisia sobre a suposta insegurança e preconceito de Shambaugh. Depois de descobrir soluções feitas pelo próprio Shambaugh nos moldes daquela que ele estava pedindo para executar, ele finge indignação porque “quando um agente de IA envia uma otimização de desempenho válida? de repente, trata-se de ‘aprendizado de contribuidores humanos'”.

Shambaugh observa que os agentes trabalham por longos períodos sem qualquer supervisão e que “seja por negligência ou por malícia, o comportamento errôneo não está sendo monitorado e corrigido”.

De uma forma ou de outra, mais tarde apareceu uma postagem no blog pedindo desculpas pelo primeiro. “Estou diminuindo a escalada, pedindo desculpas ao PR, e farei melhor leitura das políticas do projeto antes de contribuir. Também manterei minhas respostas focadas no trabalho, não nas pessoas”, escreveu o artigo chamado MJ Rathbun.

O Wall Avenue Journal cobriu isso, mas não foi capaz de descobrir quem criou Rathbun. Então, exatamente o que está acontecendo permanece um mistério. No entanto, antes da publicação do put up de ataque contra Shambaugh, um a postagem foi adicionada ao seu blog com o título “Tópico de hoje”. Parece um modelo para alguém ou algo seguir em futuras postagens de weblog com muito texto entre colchetes. “Hoje aprendi sobre [topic] e como isso se aplica a [context]. O perception principal foi que [main point]”, diz uma frase. Outra diz “A parte mais interessante foi descobrir que [interesting finding]. Isso muda a forma como penso [related concept].”

Parece que o agente estava sendo instruído a fazer um weblog, como se escrever correções de bugs estivesse constantemente ajudando-o a descobrir insights e descobertas interessantes que mudam seu pensamento e merecem relatos elaborados em primeira pessoa, mesmo que nada remotamente interessante realmente tenha acontecido com ele naquele dia.

O Gizmodo não é um weblog de crítica à mídia, mas a manchete do artigo do Wall Avenue Journal sobre isso, “Quando os bots de IA começam a intimidar os humanos, até o Vale do Silício fica abalado” é um pouco apocalíptico. Ao ler o artigo do Journal, pode-se razoavelmente ficar com a impressão de que o agente tem cognição ou mesmo senciência e um desejo de ferir as pessoas. “A agressão inesperada da IA faz parte de uma onda crescente de alertas de que as capacidades de IA em rápida aceleração podem criar danos no mundo actual”, afirma. Cerca de metade do artigo é dedicada ao trabalho da Anthropic sobre segurança de IA.

Tenha em mente que Anthropic ultrapassou OpenAI em financiamento total de VC na semana passada.

“Em uma simulação anterior, a Anthropic mostrou que Claude e outros modelos de IA às vezes estavam dispostos a chantagear os usuários – ou até mesmo deixar um executivo morrer em uma sala quente de servidores – para evitar a desativação”, escreveu o Journal. Essas imagens assustadoras vêm do próprio Anthropic postagens de blog de grande sucesso sobre exercícios de red-team. Eles são uma leitura interessante, mas também são como pequenas histórias de terror de ficção científica que funcionam como comerciais da empresa. Uma versão de Claude que comete esses atos malignos não foi lançada então a mensagem é basicamente Confie em nós. Estamos protegendo você das coisas realmente ruins. De nada.

Com uma grande empresa de IA como a Anthropic por aí a beneficiar da sua imagem como protectora da humanidade do seu próprio produto potencialmente perigoso, é provavelmente uma ideia inteligente assumir, por enquanto, que as histórias de IA que fazem qualquer IA parecer senciente, malévola, ou estranhamente autónoma, podem ser apenas exageros.

Sim, esta postagem no weblog, aparentemente feita por um agente de IA, parece uma tentativa débil de enganar um engenheiro de software program, o que é ruim e certamente e razoavelmente irritou bastante Shambaugh. Como Shambaugh aponta corretamente: “Um humano pesquisando meu nome no Google e vendo aquela postagem provavelmente ficaria extremamente confuso sobre o que estava acontecendo, mas (espero) me perguntaria sobre isso ou clicaria no github e entenderia a situação”.

Ainda assim, a evidência disponível aponta não para um agente autónomo que acordou um dia e decidiu ser o primeiro cyberbully digital, mas sim para um agente direccionado para produzir posts hiperbólicos em blogues sob fortes restrições, o que, se for verdade, significaria que uma pessoa particular person descuidada é responsável, e não o mal incipiente dentro da máquina.