Juntar-se às fileiras de um número crescente de modelos de raciocínio menores e poderosos é MiroThinker 1.5 do MiroMind, com apenas 30 bilhões de parâmetros, em comparação com as centenas de bilhões ou trilhões usados pelos principais modelos de linguagem de base (LLMs).

Mas o MiroThinker 1.5 se destaca entre esses raciocinadores menores por um motivo importante: ele oferece recursos de pesquisa de agentes que rivalizam com concorrentes de trilhões de parâmetros, como Kimi K2 e DeepSeek, por uma fração do custo de inferência.

O lançamento marca um marco na busca por agentes de IA eficientes e implantáveis. Há muito tempo, as empresas são forçadas a escolher entre chamadas de API caras para modelos de fronteira ou desempenho native comprometido. O MiroThinker 1.5 oferece um terceiro caminho: modelos de peso aberto arquitetados especificamente para uso estendido de ferramentas e raciocínio em várias etapas.

Uma das maiores tendências emergentes na indústria é a mudança de agentes altamente especializados para agentes mais generalizados. Até recentemente, essa capacidade estava amplamente limitada a modelos proprietários. O MiroThinker 1.5 representa um sério concorrente de peso aberto neste espaço. Assista meu Vídeo do YouTube nele abaixo.

Risco reduzido de alucinações por meio de raciocínio verificável

Para as equipes de TI que avaliam a implantação de IA, as alucinações continuam sendo a principal barreira ao uso de modelos abertos na produção. O MiroThinker 1.5 aborda isso por meio do que o MiroMind chama de “modo cientista” – uma mudança arquitetônica basic na forma como o modelo lida com a incerteza.

Em vez de gerar respostas estatisticamente plausíveis a partir de padrões memorizados (a causa raiz da maioria das alucinações), o MiroThinker é treinado para executar um ciclo de pesquisa verificável: propor hipóteses, consultar fontes externas em busca de evidências, identificar incompatibilidades, revisar conclusões e verificar novamente. Durante o treinamento, o modelo é explicitamente penalizado por resultados de alta confiança que não possuem suporte da fonte.

A implicação prática para a implantação empresarial é a auditabilidade. Quando o MiroThinker produz uma resposta, ele pode trazer à tona tanto a cadeia de raciocínio quanto as fontes externas que consultou. Para setores regulamentados, como serviços financeiros, saúde e jurídico, isso cria uma trilha de documentação que os modelos baseados em memorização não podem fornecer. As equipes de compliance podem revisar não apenas o que o modelo concluiu, mas como ele chegou lá.

Esta abordagem também reduz o problema da “alucinação confiante” comum em sistemas de produção de IA. O modelo é treinado para buscar verificação em vez de extrapolar quando incerto – um comportamento que se traduz diretamente em menos erros dispendiosos.

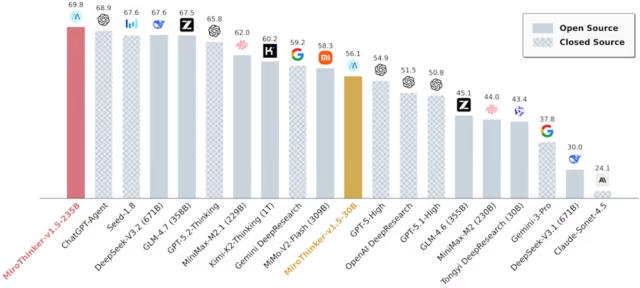

Desempenho de referência: superando seu peso

Sob esta estrutura, o MiroThinker-v1.5-30B oferece desempenho comparável a modelos com até 30x mais parâmetros, incluindo o modelo Kimi-K2-Pondering de trilhões de parâmetros.

No BrowseComp-ZH, uma referência importante para recursos de pesquisa na internet, o modelo 30B superou seu concorrente de trilhões de parâmetros com uma pontuação de 69,8.

O diferencial de custo é igualmente notável. A MiroMind relata custos de inferência tão baixos quanto US$ 0,07 por chamada para a variante 30B – aproximadamente um vigésimo do custo do Kimi-K2-Pondering – junto com velocidades de inferência mais rápidas.

Uma variante maior de 235B (com parâmetros ativos de 22B em uma arquitetura mista de especialistas) está classificada no nível superior world em vários benchmarks de agentes de pesquisa. Em avaliações gerais de busca agente, esses modelos se comparam aos sistemas DeepSeek V3.2, Minimax, GLM e Kimi-K2.

Nos testes, o modelo maior se aproxima do Gemini 3 Professional em vários benchmarks e se aproxima dos sistemas da classe GPT-5 do que sua contagem de parâmetros pode sugerir. Embora a subida de colinas seja cada vez mais comum, o que mais importa é a competitividade geral – e o MiroThinker mantém-se bem.

Uso estendido de ferramentas: até 400 chamadas de ferramentas por sessão

A capacidade definidora do MiroThinker 1.5 é o uso sustentado da ferramenta.

Os modelos suportam até 256.000 tokens de contexto e reivindicam suporte para até 400 chamadas de ferramentas por sessão – um requisito crítico para fluxos de trabalho de pesquisa complexos que envolvem ampla coleta, síntese e verificação cruzada de informações.

Isso coloca o MiroThinker firmemente na categoria emergente de modelos de agentes projetados para conclusão autônoma de tarefas, em vez de perguntas e respostas em um único turno. As aplicações práticas incluem fluxos de trabalho de pesquisa profunda, pipelines de conteúdo, geração de relatórios e resultados em estilo podcast semelhantes ao NotebookLM.

Inovação em treinamento: sandbox sensível ao tempo

Outra grande inovação no MiroThinker 1.5 é o seu Time-Delicate Coaching Sandbox.

O treinamento de modelo tradicional opera a partir do que a MiroMind descreve como uma “visão do olho de Deus”, onde o modelo tem acesso a resultados finalizados em conjuntos de dados estáticos, criando um viés retrospectivo. O treinamento do MiroThinker elimina essa vantagem.

Durante o treinamento, o modelo só pode interagir com informações publicadas antes de um determinado carimbo de knowledge/hora, evitando vazamentos futuros e forçando-o a raciocinar em condições realistas de informações incompletas.

O pipeline combina ajuste fino supervisionado com aprendizagem por reforço usando recompensas verificáveis por meio do Group Relative Coverage Optimization (GRPO), um algoritmo avançado de aprendizagem por reforço popularizado pela DeepSeek, incentivando o modelo a selecionar a ferramenta certa no momento certo.

Essa abordagem é especialmente relevante para casos de uso empresarial em que os modelos devem raciocinar sobre situações em evolução, em vez de relembrar fatos estáticos.

Considerações práticas de implantação

Para as equipes de TI que estão considerando a implantação, os requisitos de {hardware} ainda são importantes. Mesmo o modelo 30B requer uma quantidade substancial de memória de GPU e configurações menores podem ter dificuldades.

Uma vantagem é a compatibilidade. O MiroThinker é executado em servidores vLLM com endpoints de API compatíveis com OpenAI, facilitando a integração em cadeias de ferramentas existentes e fluxos de trabalho de chamada de função como um substituto imediato.

Ambos os tamanhos de modelo estão disponíveis sob a licença MIT permissiva e amigável para empresas no Hugging Face, e uma demonstração on-line está disponível para avaliação. A licença permissiva take away grandes barreiras à implantação interna e ao ajuste fino.

Visão geral: escalabilidade interativa versus escalação de parâmetros

O MiroThinker 1.5 chega no momento em que a indústria enfrenta os limites das leis tradicionais de escalabilidade. Modelos maiores não garantem mais melhor desempenho no mundo actual. Como observou a Synthetic Evaluation, muitos parâmetros de referência estão saturados, empurrando a indústria para avaliações baseadas na utilidade económica, em vez de apenas no raciocínio abstracto.

A aposta da MiroMind está no escalonamento interativo – melhorando a capacidade por meio de uma interação mais profunda com as ferramentas, em vez de contagens de parâmetros cada vez maiores. Se correto, isso poderia permitir agentes sofisticados em infraestrutura que não dependesse de APIs de fronteira caras.

A empresa, fundada por Tianqiao Chen e pelo cientista de IA Jifeng Dai, descreve sua missão como construir “Inteligência Nativa” – IA que raciocina por meio da interação, não da memorização.

Se esta abordagem se tornará dominante ou permanecerá um nicho especializado ainda é uma questão em aberto. Mas para as empresas que enfrentam compromissos entre custo e capacidade, o MiroThinker 1.5 oferece dados convincentes: por vezes, ensinar um modelo a pesquisar é mais importante do que ensiná-lo a lembrar-se de tudo.