Nos últimos dois anos, a lógica predominante na IA generativa tem sido a da força bruta: se quiser um raciocínio melhor, precisa de um modelo maior.

Embora modelos “pequenos” (abaixo de 10 bilhões de parâmetros) tenham se twister conversadores competentes, eles historicamente desmoronaram quando solicitados a realizar dedução lógica em várias etapas ou provas matemáticas complexas.

Hoje, o Instituto de Inovação Tecnológica (TII) em Abu Dhabi está desafiando essa lei de expansão com o lançamento do Falcon H1R 7B.

Ao abandonar a ortodoxia pura do Transformer em favor de uma arquitetura híbrida, a TII afirma ter construído um modelo de 7 bilhões de parâmetros que não apenas rivaliza, mas supera concorrentes quase 7X seu tamanho – incluindo as variantes 32B e 47B do Qwen do Alibaba e do Nemotron da Nvidia.

O lançamento marca uma mudança significativa no ecossistema de peso aberto, movendo o campo de batalha da contagem bruta de parâmetros para a eficiência arquitetônica e escala de tempo de inferência.

O completo o código do modelo já está disponível em Hugging Face e pode ser testado por indivíduos em uma inferência de demonstração ao vivo no Falcon Chat (uma experiência de chatbot). TII lançou ainda um relatório aparentemente bastante abrangente relatório técnico também na abordagem e metodologia de treinamento do Falcon H1 7B.

Indo além da tecnologia LLM basic, o transformador

A característica definidora do Falcon H1R 7B é seu spine “híbrido”. A maioria dos LLMs modernos depende exclusivamente da arquitetura Transformer, que é dimensionada de forma previsível, mas sofre com altos custos de memória ao processar sequências longas.

O Falcon H1R 7B integra Mamba, uma arquitetura de modelo de espaço de estados (SSM), juntamente com camadas de atenção padrão do Transformer.

Originalmente desenvolvido pelos pesquisadores Albert Gu e Tri Dao da Carnegie Mellon College e da Princeton College, o Mamba foi apresentado pela primeira vez no artigo “Mamba: Modelagem de Sequência de Tempo Linear com Espaços de Estado Seletivos“publicado em 1º de dezembro de 2023.

A arquitetura processa sequências de dados de maneira diferente dos Transformers: enquanto os Transformers comparam cada parte dos dados com todas as outras partes (escala quadrática), o Mamba processa tokens sequencialmente, permitindo lidar com grandes quantidades de informações com escala linear e custos de computação significativamente reduzidos.

Esta combinação resolve um dos gargalos mais persistentes na implantação de modelos de raciocínio: o custo de “pensar”. Os modelos de raciocínio exigem a geração de longas “cadeias de pensamento” – monólogos internos passo a passo – antes de se chegar a uma resposta. Para Transformers padrão, esses contextos longos explodem os custos computacionais.

De acordo com o relatório técnico da TII, a abordagem híbrida permite que o Falcon H1R 7B mantenha um alto rendimento mesmo à medida que o comprimento da resposta aumenta. Com um tamanho de lote de 64, o modelo processa aproximadamente 1.500 tokens por segundo por GPU – quase o dobro da velocidade do modelo concorrente Qwen3 8B.

Desempenho de referência: aumentando

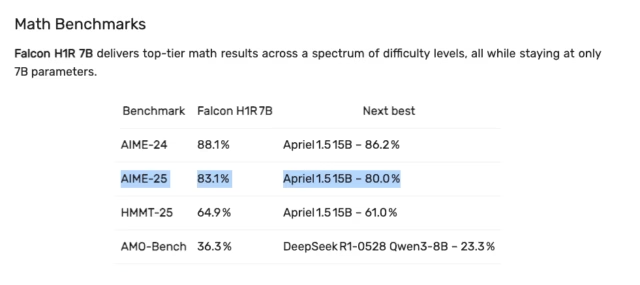

Nos benchmarks divulgados pela TII, a disparidade entre o tamanho do Falcon H1R 7B e seu desempenho é gritante. No AIME 2025 tabela de classificação – um teste rigoroso de raciocínio matemático – pontuação do Falcon H1R 7B 83,1%um resultado que perturba a hierarquia tradicional de dimensionamento de modelos.

Embora o modelo 7B percorra naturalmente enormes fronteiras proprietárias como GPT-5.2 (99,0%) e Gêmeos 3 Flash (97,0%) no índice de análise artificial separado (administrado pela organização independente de mesmo nome, que ainda não avaliou o Falcon H1R 7B), ele efetivamente reduziu a lacuna entre pesos abertos “eficientes” e sistemas proprietários de nível intermediário.

-

Vencendo “pensadores” maiores: Falcon H1R 7B (83,1%) supera o parâmetro de 15 bilhões Apriel-v1.6-Pensador (82,7%) e o parâmetro de 32 bilhões OLMo 3 Pense (73,7%), validando a afirmação da TII de que as arquiteturas híbridas podem superar os Transformers maiores.

-

Perseguindo Líderes Proprietários: Ele fica a uma distância impressionante de Soneto de Cláudio 4.5 (88,0%) e Amazon Nova 2.0 Lite (88,7%), sugerindo que, para fluxos de trabalho específicos com muita matemática, esse modelo 7B é uma alternativa viável e de baixa latência para APIs comerciais caras.

-

Superando gigantes legados: Nesta métrica de raciocínio específica, ela supera decisivamente arquiteturas amplamente capazes, mas mais antigas, como Mistral Grande 3 (38,0%) e Lhama 4 Maverick (19,3%), destacando como o treinamento de raciocínio especializado (“Deep Suppose”) se tornou mais crítico do que a escala bruta para tarefas lógicas.

Outras vitórias de domínio importantes incluem:

-

Codificação: O modelo alcançado 68,6% no benchmark LCB v6, a pontuação que o TII afirma ser a mais alta entre todos os modelos testados, incluindo aqueles quatro vezes maiores.

-

Raciocínio Geral: Embora domine em matemática e código, sua pontuação de raciocínio geral (49,48%) permanece competitiva, ficando emblem abaixo dos modelos de parâmetros 14B e 15B, mas confortavelmente à frente dos modelos 8B comparáveis.

Técnicas de treinamento

O desempenho do Falcon H1R 7B não é apenas arquitetônico; ele decorre de um pipeline de treinamento rigoroso de dois estágios, projetado para maximizar a densidade do raciocínio sem aumentar a contagem de parâmetros, de acordo com Relatório técnico da TII no modelo.

Etapa 1: Ajuste fino supervisionado de partida a frio (SFT). O modelo passou por SFT de “inicialização a frio” em um conjunto de dados curado dominado por matemática (56,8% dos tokens) e código (29,8%), com comprimentos de resposta que chegam a 48.000 tokens.

-

Ponderação consciente da dificuldade: A TII rejeitou a prática padrão de tratar todos os dados igualmente. Em vez disso, eles aplicaram um esquema de ponderação em que os problemas “difíceis” foram aumentados em 1,25x a 1,75x, enquanto os problemas fáceis foram reduzidos ou removidos inteiramente para evitar o ajuste excessivo a tarefas triviais.

-

Consistência de professor único: Estudos de ablação revelaram que a mistura de traços de raciocínio de vários modelos de “professores” na verdade prejudicou o desempenho devido a estilos de raciocínio conflitantes. Consequentemente, o TII optou por uma abordagem de professor único para manter uma lógica interna coerente.

-

Normalização de token balanceado: Para lidar com a enorme variação nos comprimentos de sequência (instruções curtas versus cadeias de raciocínio massivas), a equipe introduziu uma estratégia de normalização de token paralelo de dados balanceados. Essa técnica equaliza a contribuição do gradiente de cada token nas GPUs, evitando que classificações com sequências mais curtas desestabilizem a perda – uma mudança que rendeu um aumento consistente de precisão de 4 a ten% durante o treinamento.

Etapa 2: Aprendizagem por Reforço by way of Otimização de Política Relativa de Grupo (GRPO). Após o SFT, o modelo foi refinado usando GRPO, um algoritmo de aprendizagem por reforço que recompensa resultados corretos sem a necessidade de um modelo de valor separado.

-

A mudança “Não-KL”: Em um desvio do RLHF padrão, o TII removeu totalmente a penalidade de divergência KL (beta = 0). Isto permitiu que o modelo se desviasse significativamente da sua política básica de SFT, incentivando a exploração agressiva de novos caminhos de raciocínio.

-

Currículo somente de matemática: Surpreendentemente, o TII descobriu que o treinamento exclusivo em problemas matemáticos durante o estágio RL rendeu melhor generalização em todos os domínios – incluindo código e ciências – do que estratégias mistas. As ablações mostraram que o treinamento “somente código” melhorou as pontuações de codificação, mas prejudicou o raciocínio geral, enquanto o RL focado na matemática melhorou o desempenho globalmente.

O TII otimizou o modelo especificamente para Check-Time Scaling (TTS), uma técnica em que um modelo gera vários caminhos de raciocínio em paralelo para encontrar a melhor solução.

O modelo utiliza Deep Suppose with Confidence (DeepConf), que aproveita as pontuações de confiança internas do modelo para eliminar dinamicamente traços de raciocínio de baixa qualidade.

-

Poda Adaptativa: Durante a geração, o sistema inicia uma fase de “aquecimento” com 16 traços para estabelecer uma linha de base de confiança. Em seguida, ele filtra agressivamente os rastreamentos subsequentes, encerrando qualquer cadeia que fique abaixo do 10º percentil da confiança da linha de base.

-

Ganhos de eficiência: Este método cria uma nova fronteira de Pareto para implantação. Em testes de benchmark, o Falcon H1R 7B alcançou 96,7% de precisão no AIME 25, reduzindo o uso de token em 38% em comparação com a linha de base DeepSeek-R1-0528-Qwen3-8B.

Licenciamento: aberto para uso comercial, mas com restrições

TII lançou Falcon H1R 7B sob o costume Licença Falcon LLM 1.0 baseado no Apache 2.0 — mas com modificações notáveis — principalmente entre elas: não litigar contra o TII, e também sempre creditá-lo.

Para desenvolvedores e startups, a licença é amplamente permissiva:

-

Livre de royalties: Os usuários podem executar, modificar e distribuir o modelo comercialmente sem pagar TII.

-

Atribuição: Qualquer trabalho derivado (incluindo ajustes finos) deve indicar com destaque: “[Name of work] é construído usando a tecnologia Falcon LLM do Expertise Innovation Institute”.

No entanto, ao contrário de uma licença pura da Open Supply Initiative (OSI), a licença Falcon inclui uma rigorosa Política de Uso Aceitável (AUP).

A licença termina automaticamente se o modelo for usado para criar trabalho que entre em conflito com a AUP ou se o usuário iniciar um litígio de patente contra a TII.

Especificamente, a AUP proíbe o uso do Falcon H1R 7B ou seus derivados para:

-

Violação de leis: Qualquer uso que viole leis ou regulamentos nacionais, federais, estaduais, locais ou internacionais aplicáveis.

-

Danos a Menores ou Seres Vivos: Explorar, prejudicar ou tentar explorar ou prejudicar menores ou quaisquer seres vivos.

-

Desinformação: Gerar ou disseminar informações comprovadamente falsas com o objetivo de prejudicar terceiros.

-

Assédio: Difamar, depreciar ou de outra forma assediar outras pessoas.

A onda híbrida: Nvidia, IBM, AI21 e Mistral

A TII não está sozinha na aposta neste futuro híbrido; a indústria está cada vez mais migrando para arquiteturas que combinem os pontos fortes dos SSMs e dos Transformers.

-

Nvidia estreou recentemente o Família Nemotron 3 em 15 de dezembro de 2025, que utiliza uma mistura híbrida de especialistas (MoE) e um design Mamba-Transformer para impulsionar uma IA agente eficiente.

-

IBM lançou seu Família Granito 4.0 em 2 de outubro de 2025, usando uma arquitetura híbrida Mamba-Transformer para reduzir os requisitos de memória em mais de 70%, mantendo o alto desempenho em benchmarks empresariais.

-

AI21 seguiu esse caminho com seus modelos Jamba (Joint Consideration e Mamba), lançando o Família Jamba 1.5 em 22 de agosto de 2024, para aumentar as capacidades de IA da agência por meio de uma abordagem híbrida SSM-Transformer.

-

Mistral entrou cedo no espaço com Mamba Codestral em 16 de julho de 2024, um modelo otimizado especificamente para geração de código mais rápida e longa.

O Falcon H1R 7B representa a mais recente evolução nesta tendência, visando especificamente tarefas de raciocínio denso em um formato compacto.