Siga ZDNET: Adicione-nos como fonte preferencial no Google.

Principais conclusões da ZDNET

- Reins é uma interface GUI gratuita para Ollama.

- O sistema só funciona em MacOS.

- Reins inclui recursos não encontrados em outras GUIs.

Quando preciso usar IA, minha primeira escolha é sempre native por questões de privacidade, e na maioria das vezes é by way of Ollama. Posso usar as ferramentas de linha de comando do Ollama perfeitamente, mas certos recursos em várias GUIs aprimoram e simplificam a experiência.

Embora Ollama tenha sua própria GUI bem projetada e fácil de usar, é um pouco básico para mim.

Além disso: 5 razões pelas quais uso IA native em minha área de trabalho – em vez de ChatGPT, Gemini ou Claude

Outra opção é o Reins, que capacita pesquisadores e amadores com controle complete sobre modelos auto-hospedados.

Reins tem muitos recursos, como acesso remoto a modelos, prompts de sistema por chat, edição e regeneração de prompts, integração de imagens, configuração avançada, seleção de modelo, criação de modelo a partir de prompts, gerenciamento de vários chats, troca dinâmica de modelos e streaming de mensagens em tempo actual.

Além disso: experimentei um rival do Claude Code que é native, de código aberto e totalmente gratuito – como foi

Todos esses recursos se unem para fazer de Reins minha nova opção para trabalhar com LLMs locais de Ollama.

Vamos instalar o Reins e ver como funcionam alguns desses recursos mais importantes.

Instalando Rédeas

O que você precisa: Reins é um aplicativo gratuito somente para MacOS, portanto, se você estiver usando Linux ou Home windows, terá que recorrer a outra GUI (como o aplicativo oficial Ollama ou Alpaca).

Para usar o Reins, você precisará do Ollama instalado (baixe o instalador do site oficial) e, claro, um Mac. Você pode conectar o Reins a uma instância do Ollama em outra máquina em sua LAN ou pode instalar o Ollama na máquina que hospedará o Reins.

Para instalar o Reins, clique no botão Obter e permita que a instalação comece e termine.

Mostrar mais

É isso para a instalação.

Usando Rédeas

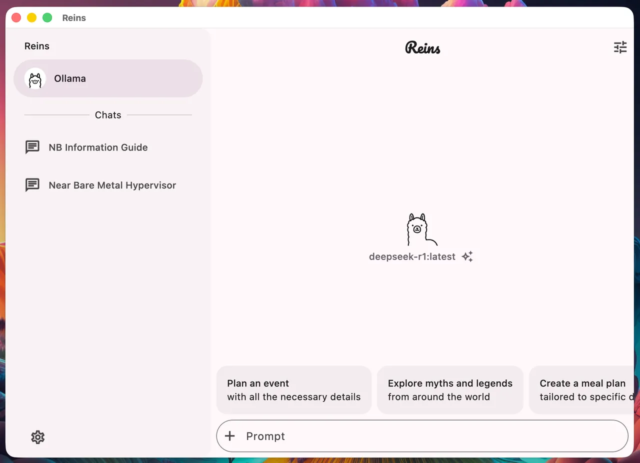

Rédeas é muito simples de usar. Depois de abrir o aplicativo, você verá que ele está conectado ao Ollama.

Além disso: parei de usar ChatGPT para tudo: esses modelos de IA superam em pesquisa, codificação e muito mais

Ao digitar seu immediate inicial, você será solicitado a selecionar um modelo. Depois de selecionar seu modelo, você pode enviar sua solicitação e Reins fará o seu trabalho:

A GUI do Reins é muito fácil de usar.

Captura de tela de Jack Wallen/ZDNET

Um dos recursos mais legais do Reins é que você pode trocar de modelo rapidamente. Para fazer isso, clique no nome do modelo na parte superior (sob o título Reins) e selecione o modelo que deseja usar.

Enquanto Ollama está trabalhando em um immediate, você pode selecionar um immediate anterior, trocar de modelo e continuar trabalhando. Você não obtém esse tipo de flexibilidade com algumas GUIs do Ollama:

Troque de modelo rapidamente clicando no menu suspenso de nomes em Rédeas.

Captura de tela de Jack Wallen/ZDNET

Você pode até adicionar arquivos às suas consultas clicando em + diretamente à esquerda do campo de immediate. A única ressalva desse recurso é que ele é limitado ao add de imagens.

Além disso: 5 maneiras de parar de testar IA e começar a escalá-la com responsabilidade em 2026

Se você tiver um documento de texto, poderá copiá-lo e colá-lo no campo de consulta. Ao fazer isso, Reins usará qualquer modelo que você tenha selecionado para resumir o materials.

Um recurso útil (que não funciona… ainda)

Há um recurso que me deixou animado para usar o Reins, embora atualmente esteja falhando.

Digamos que passei um bom tempo em um único immediate, fazendo perguntas complementares, adicionando pesquisas e imagens e muito mais. Posso passar uma semana trabalhando nessa pesquisa. Quando sinto que a pesquisa está concluída, posso salvá-la como modelo para consultas posteriores.

Para salvar um immediate como modelo, selecione-o na barra lateral e clique no ícone Configurações no canto superior direito da janela Reins. No pop-up resultante, clique em “Salvar como novo modelo”, que abrirá um novo pop-up que requer um nome:

Esperançosamente, o recurso Salvar como modelo funcionará em versões futuras.

Captura de tela de Jack Wallen/ZDNET

Tenho tentado fazer esse recurso funcionar, mas ele continua falhando.

Até perguntei a Reins, brincando, por que o recurso não estava funcionando e, para minha surpresa, ele ofereceu alguns conselhos úteis. Infelizmente, as sugestões não funcionaram.

Além disso: 5 maneiras pelas quais regras e regulamentos podem ajudar a orientar sua inovação em IA

Entrei em contato com o desenvolvedor para ver se havia uma solução. Ele respondeu: “Vou investigar isso e também vou lançar uma nova atualização para melhorar os erros e mostrar a mensagem de erro exata em breve. Avisarei você quando eu corrigir o problema.”

Isso é reconfortante. Apesar desse recurso (temporariamente) quebrado, descobri que Reins é um excelente frontend para Ollama. Embora também seja fã da versão terminal do Ollama, gosto de uma boa GUI. Se você usa MacOS, sugiro que experimente este.