Modelos de linguagem recursiva (RLMs) são uma técnica de inferência desenvolvida por pesquisadores do MIT CSAIL que tratam prompts longos como um ambiente externo ao modelo. Em vez de forçar todo o immediate na janela de contexto do modelo, a estrutura permite que o LLM look at, decomponha e chame a si mesmo recursivamente sobre trechos do texto.

Em vez de expandir as janelas de contexto ou resumir informações antigas, a equipe do MIT reformula o raciocínio de longo contexto como um problema de sistema. Ao permitir que os modelos tratem os prompts como algo que podem inspecionar com código, os modelos de linguagem recursiva permitem que os LLMs raciocinem sobre milhões de tokens sem retreinamento. Isso oferece às empresas um caminho prático para tarefas de longo prazo, como análise de base de código, revisão jurídica e raciocínio em várias etapas que quebram rotineiramente os modelos atuais.

Como a estrutura foi projetada como um wrapper em torno de modelos existentes, ela pode servir como um substituto imediato para aplicativos que fazem chamadas diretas para LLMs.

O problema do contexto LLM

Embora os modelos de fronteira estejam a tornar-se cada vez mais sofisticados em termos de raciocínio, a sua capacidade de processar grandes quantidades de informação não está a crescer ao mesmo ritmo. Esse gargalo é impulsionado por duas limitações distintas: a forte restrição física sobre a quantidade de texto que um modelo pode processar de uma vez (comprimento do contexto) e a “apodrecimento do contexto”.

O desafio, argumentam os pesquisadores, é se é possível dimensionar o tamanho efetivo do contexto dos LLMs de uso geral em ordens de grandeza sem treiná-los novamente. Esta capacidade está se tornando cada vez mais importante para aplicações empresariais, onde os LLMs são adotados para tarefas de longo prazo que exigem o processamento de milhões de tokens – um desafio que Zhang argumenta que não pode ser resolvido simplesmente expandindo as janelas de contexto.

“Há um argumento de entropia que implica que você precisa de exponencialmente mais amostras de dados à medida que aumenta o tamanho efetivo da janela de contexto”, disse Alex Zhang, coautor do artigo, ao VentureBeat.

As abordagens atuais para ampliar o contexto geralmente dependem da compactação, onde o modelo resume partes mais antigas da conversa para liberar espaço. No entanto, esse método falha em tarefas que exigem acesso aleatório a detalhes específicos localizados em partes anteriores do immediate.

Como funcionam os RLMs

O conceito por trás dos RLMs é extraído de algoritmos “out-of-core” usados na computação clássica. Esses algoritmos são projetados para processar conjuntos de dados grandes demais para caber na memória principal de um computador, mantendo os dados em um disco rígido e buscando apenas os pedaços necessários, conforme necessário.

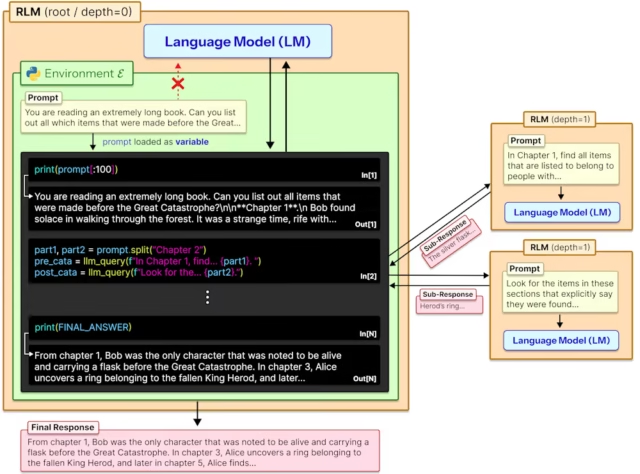

Os RLMs aplicam esta lógica à IA generativa. Em vez de alimentar um immediate longo diretamente na rede neural, a estrutura carrega o texto como uma variável de string dentro de um ambiente de codificação Python. O LLM recebe um contexto geral sobre os dados (como a contagem complete de caracteres), mas não “vê” o texto inicialmente.

Uma vez que o immediate é armazenado como uma variável, o LLM atua como um programador. Ele escreve código Python para interagir com a variável externa, usando comandos padrão para espiar os dados. Por exemplo, o modelo pode usar expressões regulares para pesquisar palavras-chave específicas como “Capítulo 1” ou “resultados financeiros”.

Quando a execução do código encontra um trecho relevante, o RLM puxa apenas aquele pedaço específico para sua janela de contexto ativa para análise.

Por exemplo, se o immediate for um livro enorme, o LLM pode escrever um loop que identifica os limites do capítulo e, em seguida, aciona uma subchamada para resumir cada capítulo individualmente.

A arquitetura normalmente envolve dois agentes. Um “modelo de linguagem raiz”, geralmente um modelo com muitos recursos como o GPT-5, atua como orquestrador. Ele planeja a abordagem, escreve o código e gerencia o fluxo de dados no ambiente REPL. Um “modelo de linguagem recursiva”, muitas vezes um modelo mais rápido e mais barato, atua como trabalhador. O LM raiz chama esse trabalhador para processar os trechos de texto específicos isolados pelo código.

Como o immediate reside na memória do ambiente e não na janela de contexto do modelo, o sistema pode manipular entradas muito maiores que o limite de treinamento do modelo. É importante ressaltar que para o usuário ultimate o RLM se comporta exatamente como um modelo padrão: ele aceita uma string e retorna uma resposta. Isso permite que as equipes empresariais troquem chamadas de API padrão por RLMs.

Para desenvolvedores que desejam experimentar, o código RLM está atualmente disponível em GitHub.

“Um argumento chave para os RLMs é que as tarefas mais complexas podem ser decompostas em subtarefas ‘locais’ menores”, disse Zhang. “No entanto, como realizar essa decomposição contexto/problema não é trivial, e o modelo deve ser capaz de realizar isso.”

RLMs em ação

Para validar a estrutura, os pesquisadores testaram RLMs em modelos básicos e outras abordagens de agente, como CodeAct e agentes de resumo, em uma variedade de tarefas de longo contexto, incluindo recuperação e resposta a perguntas multi-hop.

Os resultados demonstraram fortes ganhos de desempenho na escala de mais de 10 milhões de tokens. Sobre BrowseComp Plusum benchmark envolvendo entradas de 6 a 11 milhões de tokens, os modelos básicos padrão falharam completamente, pontuando 0%. Em contraste, o RLM alimentado por GPT-5 alcançou pontuação de 91,33%, superando significativamente o Agente Resumo (70,47%) e CodeAct (51%).

O framework também se destacou em tarefas com alta complexidade computacional. Em OOLONG-Pairs, um benchmark de raciocínio denso em informações onde a dificuldade aumenta quadraticamente com o comprimento da entrada, os modelos básicos do GPT-5 falharam catastroficamente com uma pontuação de apenas 0,04%. O RLM alcançou uma pontuação F1 (uma medida equilibrada de precisão e recall) de 58%, demonstrando capacidades emergentes para lidar com tarefas densas que paralisam os modelos padrão. Da mesma forma, em tarefas de compreensão de código (benchmark CodeQA), o RLM mais que dobrou o desempenho do modelo básico GPT-5, saltando de 24% para 62%.

Em relação ao problema de podridão de contexto, os dados mostraram que, embora o desempenho básico do GPT-5 se degrade rapidamente à medida que a complexidade da tarefa aumenta, o desempenho do RLM se mantém estável, superando consistentemente o modelo básico em contextos com mais de 16.000 tokens.

Apesar da maior complexidade do fluxo de trabalho, os RLMs mantiveram frequentemente custos médios comparáveis ou inferiores aos das linhas de base. No benchmark BrowseComp-Plus, o RLM foi até três vezes mais barato que a linha de base do resumo.

No entanto, os pesquisadores observaram que, embora os custos médios sejam baixos, as trajetórias do RLM são de “cauda longa”. Execuções atípicas podem se tornar caras se o modelo ficar preso em loops ou realizar verificações redundantes. Embora o GPT-5 fosse conservador em suas subchamadas, o código aberto Codificador Qwen3 o modelo às vezes tentava milhares de subchamadas para tarefas simples.

“Hoje, você provavelmente terá que implementar suas próprias proteções e lógica para controlar o comportamento do RLM”, disse Zhang. No entanto, ele levanta a hipótese de que modelos futuros poderiam ser treinados para gerenciar seus próprios orçamentos de computação de forma mais eficaz. Empresas como a Prime Mind estão planejando integrar RLM no processo de treinamento de modelos, possivelmente abordando os casos extremos em que o orçamento de inferência do modelo aumenta.

Para arquitetos empresariais que decidem onde fazer suas apostas, a estrutura RLM oferece uma nova ferramenta para lidar com problemas com muita informação.

“Acho que os RLMs ainda são extremamente úteis para chatbots (pense em longos históricos de bate-papo), mas, em última análise, eles defendem uma forma alternativa de usar os LMs”, disse Zhang. “Acho que os RLMs funcionam em conjunto com métodos de recuperação padrão como o RAG; eles não servem como substitutos e podem ser usados em ambientes diferentes ou em conjunto.”