Inicialização de IA chinesa MiniMaxcom sede em Xangai, enviou ondas de choque pela indústria de IA hoje com o lançamento de seu novo Modelo de linguagem M2.5 em duas variantes, que prometem tornar a inteligência synthetic de ponta tão barata que você pode parar de se preocupar totalmente com a conta.

Também é dito que “código aberto,” embora os pesos (configurações) e o código ainda não tenham sido publicados, nem o tipo ou os termos exatos da licença. Mas isso é quase irrelevante, dado o quão barato o MiniMax está servindo por meio de sua API e de parceiros.

Nos últimos anos, usar a IA mais poderosa do mundo period como contratar um consultor caro – period brilhante, mas você observava o relógio (e a contagem de tokens) constantemente. M2.5 muda essa matemática, reduzindo o custo da fronteira em até 95%.

Ao oferecer desempenho que rivaliza com os modelos de primeira linha do Google e da Anthropic por uma fração do custo, especialmente no uso de ferramentas de agente para tarefas empresariais, incluindo criação de arquivos Microsoft Phrase, Excel e PowerPointMiniMax está apostando que o futuro não depende apenas de quão inteligente é um modelo, mas de quantas vezes você pode usá-lo.

Na verdade, para este fim, a MiniMax diz que trabalhou “com profissionais seniores em áreas como finanças, direito e ciências sociais” para garantir que o modelo pudesse realizar um trabalho actual de acordo com as suas especificações e padrões.

Esta versão é importante porque sinaliza uma mudança da IA como um “chatbot” para a IA como um “trabalhador”. Quando a inteligência se torna “muito barata para medir”, os desenvolvedores param de construir ferramentas simples de perguntas e respostas e começam a construir “agentes” – software program que pode passar horas codificando, pesquisando e organizando projetos complexos de forma autônoma, sem gastar muito.

Na verdade, a MiniMax já implantou esse modelo em suas próprias operações. Atualmente, 30% de todas as tarefas na sede da MiniMax são concluídas até M2.5e uma impressionante 80% do código recém-comprometido é gerado pelo M2.5!

Como escreve a equipe MiniMax em seu weblog de lançamento, “acreditamos que o M2.5 oferece possibilidades virtualmente ilimitadas para o desenvolvimento e operação de agentes na economia”.

Tecnologia: energia escassa e o avanço da CISPO

O segredo da eficiência do M2.5 está na sua arquitetura Combination of Consultants (MoE). Em vez de executar todos os seus 230 bilhões de parâmetros para cada palavra que gera, o modelo apenas “ativa” 10 bilhões. Isso permite manter a profundidade de raciocínio de um modelo enorme enquanto se transfer com a agilidade de um modelo muito menor.

Para treinar esse sistema complexo, a MiniMax desenvolveu uma estrutura proprietária de Reinforcement Studying (RL) chamada Forge. Engenheiro MiniMax Canção de Oliveira declarado no Podcast de quinta-feira AI no YouTube que esta técnica foi elementary para dimensionar o desempenho mesmo usando um número relativamente pequeno de parâmetros, e que o modelo foi treinado durante um período de dois meses.

O Forge foi projetado para ajudar o modelo a aprender com “ambientes do mundo actual” – essencialmente permitindo que a IA pratique a codificação e o uso de ferramentas em milhares de espaços de trabalho simulados.

“O que percebemos é que há muito potencial em um modelo pequeno como este se treinarmos nele o aprendizado por reforço com uma grande quantidade de ambientes e agentes”, disse Track. “Mas não é uma coisa muito fácil de fazer”, acrescentando que foi nisso que eles gastaram “muito tempo”.

Para manter o modelo estável durante esse treinamento intenso, eles usaram uma abordagem matemática chamada CISPO (Clipping Significance Sampling Coverage Optimization) e compartilharam a fórmula em seu weblog.

Esta fórmula garante que o modelo não corrija excessivamente durante o treinamento, permitindo-lhe desenvolver o que o MiniMax chama de “Mentalidade do Arquiteto”. Em vez de começar a escrever código, o M2.5 aprendeu primeiro a planejar proativamente a estrutura, os recursos e a interface de um projeto.

Benchmarks de última geração (e próximos)

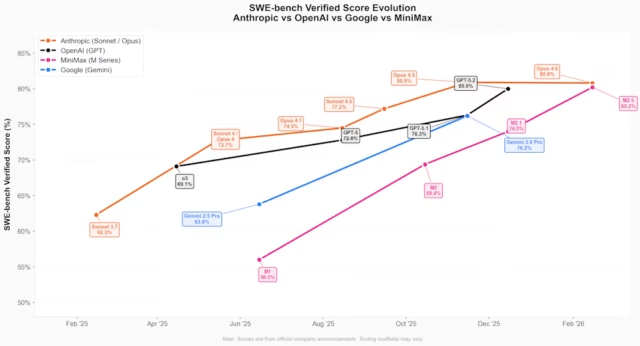

Os resultados desta arquitetura são refletidos nos últimos rankings do setor. M2.5 não apenas melhorou; ele saltou para o nível superior de modelos de codificação, aproximando-se do modelo mais recente da Anthropic, Claude Opus 4.6, lançado há apenas uma semana, e mostrando que as empresas chinesas estão agora a poucos dias de alcançar laboratórios americanos com recursos muito melhores (em termos de GPUs).

Aqui estão alguns dos novos destaques do benchmark MiniMax M2.5:

-

Banco SWE verificado: 80,2% – Corresponde às velocidades de Claude Opus 4,6

-

NavegarComp: 76,3% — Pesquisa e uso de ferramentas líderes do setor.

-

Banco Multi-SWE: 51,3% — SOTA em codificação multilíngue

-

BFCL (chamada de ferramenta): 76,8% — Fluxos de trabalho de agentes de alta precisão.

No podcast ThursdAI, o apresentador Alex Volkov apontou que o MiniMax M2.5 opera extremamente rápido e, portanto, usa menos tokens para concluir tarefas, na ordem de US$ 0,15 por tarefa, em comparação com US$ 3,00 para Claude Opus 4.6.

Quebrando a barreira do custo

MiniMax está oferecendo duas versões do modelo por meio de sua API, ambas focadas no uso em produção de alto quantity:

-

M2.5-Relâmpago: Otimizado para velocidade, entregando 100 tokens por segundo. Custa US$ 0,30 por 1 milhão de tokens de entrada e US$ 2,40 por 1 milhão de tokens de saída.

-

Padrão M2.5: Otimizado para custo, rodando a 50 tokens por segundo. Custa metade do preço da versão Lightning (US$ 0,15 por 1 milhão de tokens de entrada / US$ 1,20 por 1 milhão de tokens de saída).

Em linguagem simples: o MiniMax afirma que você pode administrar quatro “agentes” (trabalhadores de IA) continuamente durante um ano inteiro por cerca de US$ 10.000.

Para usuários corporativos, esse preço é de aproximadamente 1/10 a 1/20 do custo de modelos proprietários concorrentes, como GPT-5 ou Claude 4.6 Opus.

|

Modelo |

Entrada |

Saída |

Custo complete |

Fonte |

|

Qwen3 Turbo |

US$ 0,05 |

US$ 0,20 |

US$ 0,25 |

|

|

deepseek-chat (V3.2-Exp) |

US$ 0,28 |

US$ 0,42 |

US$ 0,70 |

|

|

raciocinador de busca profunda (V3.2-Exp) |

US$ 0,28 |

US$ 0,42 |

US$ 0,70 |

|

|

Grok 4.1 Rápido (raciocínio) |

US$ 0,20 |

US$ 0,50 |

US$ 0,70 |

|

|

Grok 4.1 Rápido (sem raciocínio) |

US$ 0,20 |

US$ 0,50 |

US$ 0,70 |

|

|

MiniMax M2.5 |

US$ 0,15 |

US$ 1,20 |

US$ 1,35 |

|

|

MiniMax M2.5-Relâmpago |

US$ 0,30 |

US$ 2,40 |

US$ 2,70 |

|

|

Pré-visualização em Flash do Gêmeos 3 |

US$ 0,50 |

US$ 3,00 |

US$ 3,50 |

|

|

Kimi-k2.5 |

US$ 0,60 |

US$ 3,00 |

US$ 3,60 |

|

|

GLM-5 |

US$ 1,00 |

US$ 3,20 |

US$ 4,20 |

|

|

ERNIE 5.0 |

US$ 0,85 |

US$ 3,40 |

US$ 4,25 |

|

|

Claude Haiku 4.5 |

US$ 1,00 |

US$ 5,00 |

US$ 6,00 |

|

|

Qwen3-Max (23/01/2026) |

US$ 1,20 |

US$ 6,00 |

US$ 7,20 |

|

|

Gêmeos 3 Professional (≤200K) |

US$ 2,00 |

US$ 12,00 |

US$ 14,00 |

|

|

GPT-5.2 |

US$ 1,75 |

US$ 14,00 |

US$ 15,75 |

|

|

Soneto de Claude 4.5 |

US$ 3,00 |

US$ 15,00 |

US$ 18,00 |

|

|

Gêmeos 3 Professional (>200K) |

US$ 4,00 |

US$ 18,00 |

US$ 22,00 |

|

|

Claude Opus 4.6 |

US$ 5,00 |

US$ 25,00 |

US$ 30,00 |

|

|

GPT-5.2 Pró |

US$ 21,00 |

US$ 168,00 |

US$ 189,00 |

Implicações estratégicas para empresas e líderes

Para os líderes técnicos, o M2.5 representa mais do que apenas uma API mais barata. Isso muda o guide operacional das empresas neste momento.

A pressão para “otimizar” os prompts para economizar dinheiro acabou. Agora você pode implantar modelos de alto contexto e raciocínio para tarefas rotineiras que antes tinham custos proibitivos.

A melhoria de 37% na velocidade na conclusão de tarefas de ponta a ponta significa que os pipelines “agentes” valorizados pelos orquestradores de IA – onde os modelos se comunicam com outros modelos – finalmente se movem com rapidez suficiente para aplicativos de usuário em tempo actual.

Além disso, as pontuações elevadas do M2.5 em modelização financeira (74,4% no MEWC) sugerem que este pode lidar com o “conhecimento tácito” de indústrias especializadas, como o direito e as finanças, com supervisão mínima.

Como o M2.5 está posicionado como um modelo de código aberto, as organizações podem potencialmente executar auditorias de código intensivas e automatizadas em uma escala que antes period impossível sem intervenção humana massiva, ao mesmo tempo em que mantêm um melhor controle sobre a privacidade dos dados, mas até que os termos e pesos de licenciamento sejam publicados, isso permanece apenas um apelido.

O MiniMax M2.5 é um sinal de que a fronteira da IA não se trata mais apenas de quem pode construir o maior cérebro, mas de quem pode tornar esse cérebro o trabalhador mais útil – e acessível – da sala.