Quando as empresas ajustam os LLMs para novas tarefas, correm o risco de quebrar tudo o que os modelos já sabem. Isto obriga as empresas a manter modelos separados para cada habilidade.

Pesquisadores do MIT, do Improvable AI Lab e da ETH Zurich desenvolveram uma nova técnica que permite que grandes modelos de linguagem aprendam novas habilidades e conhecimentos sem esquecer suas capacidades anteriores.

Sua técnica, chamada ajuste fino de autodestilação (SDFT), permite que os modelos aprendam diretamente a partir de demonstrações e de seus próprios experimentos, aproveitando as habilidades inerentes de aprendizagem no contexto dos LLMs modernos. Experimentos mostram que o SDFT supera consistentemente o ajuste fino supervisionado tradicional (SFT), ao mesmo tempo que aborda as limitações dos algoritmos de aprendizagem por reforço.

Para aplicações empresariais, o método permite que um único modelo acumule múltiplas habilidades ao longo do tempo sem sofrer regressão de desempenho em tarefas anteriores. Isto oferece um caminho potencial para a construção de agentes de IA que possam se adaptar a ambientes de negócios dinâmicos, reunindo novos conhecimentos e habilidades proprietários conforme necessário, sem exigir ciclos de reciclagem caros ou perder suas habilidades gerais de raciocínio.

O desafio da aprendizagem contínua

Depois que um LLM é treinado e implantado, ele permanece estático. Não atualiza seus parâmetros para adquirir novas competências, internalizar novos conhecimentos ou melhorar a partir da experiência. Para construir uma IA verdadeiramente adaptativa, a indústria precisa resolver “aprendizagem contínua”, permitindo que os sistemas acumulem conhecimento da mesma forma que os humanos fazem ao longo de suas carreiras.

A forma mais eficaz de os modelos aprenderem é através da “aprendizagem baseada em políticas”. Nesta abordagem, o modelo aprende com os dados que ele próprio gera, permitindo-lhe corrigir os seus próprios erros e processos de raciocínio. Isso contrasta com o aprendizado simplesmente imitando conjuntos de dados estáticos. Sem aprendizagem sobre políticas, os modelos são propensos a “esquecimento catastrófico,” um fenômeno em que aprender uma nova tarefa faz com que o modelo perca seu conhecimento anterior e a capacidade de realizar tarefas anteriores.

No entanto, a aprendizagem sobre políticas normalmente requer aprendizagem por reforço (RL), que depende de uma função de recompensa explícita para pontuar os resultados do modelo. Isso funciona bem para problemas com resultados claros, como matemática e codificação. Mas em muitos cenários empresariais do mundo actual (por exemplo, redigindo um resumo jurídico ou resumindo uma reunião), definir uma função matemática de recompensa é difícil ou impossível.

Os métodos RL também falham frequentemente ao tentar ensinar a um modelo informações inteiramente novas, como um protocolo específico da empresa ou uma nova linha de produtos. Como Idan Shenfeld, estudante de doutorado no MIT e coautor do artigo, disse ao VentureBeat: “Não importa quantas vezes o modelo básico tente, ele não consegue gerar respostas corretas para um tópico sobre o qual não tem conhecimento”, o que significa que nunca recebe um sinal positivo para aprender.

A alternativa padrão é o ajuste fino supervisionado (SFT), onde o modelo é treinado em um conjunto fixo de dados de demonstrações de especialistas. Embora o SFT forneça uma verdade clara, é inerentemente “fora da política”. Como o modelo apenas imita dados em vez de aprender com as suas próprias tentativas, muitas vezes não consegue generalizar para exemplos fora de distribuição e sofre gravemente de esquecimento catastrófico.

O SDFT procura colmatar esta lacuna: permitindo os benefícios da aprendizagem sobre políticas utilizando apenas demonstrações pré-gravadas, sem necessidade de uma função de recompensa.

Como funciona o SDFT

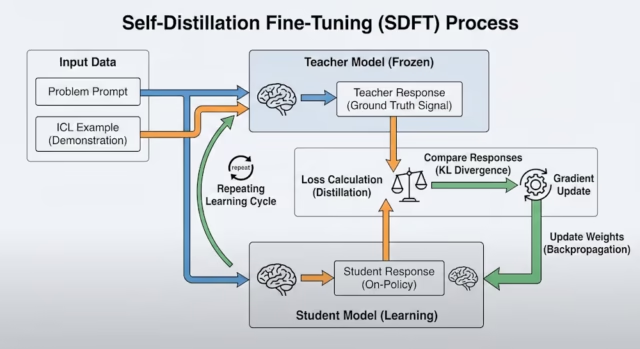

SDFT resolve esse problema usando “destilação”, um processo em que um modelo de aluno aprende a imitar um professor. A ideia dos pesquisadores foi usar os próprios recursos de “aprendizado em contexto” (ICL) do modelo para criar um ciclo de suggestions dentro de um único modelo.

A aprendizagem contextual é o fenômeno em que você fornece ao LLM uma tarefa difícil e uma ou mais demonstrações de como problemas semelhantes são resolvidos. A maioria dos LLMs avançados são projetados para resolver novos problemas com exemplos de ICL, sem nenhuma atualização de parâmetros.

Durante o ciclo de treinamento, o SDFT emprega o modelo em duas funções.

O professor: Uma versão congelada do modelo alimenta a consulta junto com demonstrações de especialistas. Utilizando a ICL, o professor deduz a resposta correta e a lógica de raciocínio necessária para alcançá-la.

O aluno: Esta versão vê apenas a consulta, simulando um cenário de implantação actual onde nenhuma chave de resposta está disponível.

Quando o aluno gera uma resposta, o professor, que tem acesso às demonstrações dos especialistas, dá suggestions. O aluno então atualiza seus parâmetros para alinhá-los mais próximo da distribuição do professor.

Este processo cria efetivamente um ciclo de aprendizagem sobre políticas, combinando elementos de SFT e RL. A supervisão não provém de um conjunto de dados estáticos, mas da própria interação e dos resultados do modelo. Permite que o modelo corrija suas próprias trajetórias de raciocínio sem exigir um sinal de recompensa externo. Este processo funciona mesmo para novos conhecimentos que RL perderia.

SDFT em ação

Para validar a abordagem, os pesquisadores testaram o SDFT usando o peso aberto Modelo Qwen 2.5 em três habilidades complexas de nível empresarial: perguntas e respostas científicas, uso de ferramentas de software program e raciocínio médico.

Os resultados mostraram que o SDFT aprendeu novas tarefas de forma mais eficaz do que os métodos padrão. No benchmark Science Q&A, o modelo SDFT alcançou 70,2% de precisão, em comparação com 66,2% para a abordagem SFT padrão.

Mais importante para a adoção empresarial é o impacto no esquecimento catastrófico. Quando o modelo SFT padrão aprendeu a tarefa científica, sua capacidade de responder questões gerais (como lógica ou humanidades) entrou em colapso. Em contraste, o modelo SDFT melhorou a tarefa científica, mantendo a pontuação das “Tarefas Anteriores” estável em 64,5%. Esta estabilidade sugere que as empresas poderiam especializar modelos para departamentos específicos (por exemplo, RH ou Jurídico) sem degradar o bom senso básico ou as capacidades de raciocínio do modelo.

A equipe também simulou um cenário de injeção de conhecimento, criando um conjunto de dados de “Desastres Naturais de 2025” fictícios para ensinar novos fatos ao modelo. Eles testaram o modelo em questões de raciocínio indireto, como “Dadas as enchentes de 2025, quais países provavelmente precisariam de ajuda humanitária?”

O SFT padrão resultou em um modelo que memorizava fatos, mas tinha dificuldade para usá-los em cenários de raciocínio. O modelo SDFT, tendo internalizado a lógica durante o treinamento, obteve 98% nas mesmas questões.

Finalmente, os pesquisadores conduziram um experimento de aprendizagem sequencial, treinando o modelo em ciência, uso de ferramentas e tarefas médicas, um após o outro. Enquanto o desempenho do modelo padrão oscilava, perdendo competências anteriores à medida que aprendia novas, o modelo SDFT acumulou com sucesso todas as três competências sem regressão.

Esse recurso aborda um grande problema para as empresas que atualmente gerenciam “zoológicos modelo” de adaptadores separados para tarefas diferentes.

“Oferecemos a capacidade de manter apenas um modelo único para todas as necessidades da empresa”, disse Shenfeld. Esta consolidação “pode levar a uma redução substancial nos custos de inferência” porque as organizações não precisam de hospedar vários modelos simultaneamente.

Limitações e disponibilidade do SDFT

O código para SDFT está disponível no GitHub e pronto para ser integrado aos fluxos de trabalho de treinamento de modelos existentes.

“O pipeline SDFT é mais semelhante ao pipeline RL porque requer geração de resposta on-line durante o treinamento”, disse Shenfeld. Eles estão trabalhando com o Hugging Face para integrar o SDFT ao último Aprendizagem por reforço de transformador (TRL), acrescentou, observando que uma solicitação pull já está aberta para desenvolvedores que desejam testar a integração.

Para as equipes que estão considerando o SDFT, as compensações práticas se resumem ao tamanho do modelo e à computação. A técnica requer modelos com aprendizagem contextual forte o suficiente para atuarem como seus próprios professores – atualmente cerca de 4 bilhões de parâmetros com arquiteturas mais recentes como Qwen 3, embora Shenfeld espere que modelos de 1 bilhão de parâmetros funcionem em breve. Exige cerca de 2,5 vezes o cálculo do ajuste fino padrão, mas é mais adequado para organizações que precisam de um modelo único para acumular múltiplas habilidades ao longo do tempo, especialmente em domínios onde definir uma função de recompensa para aprendizagem por reforço é difícil ou impossível.

Embora eficaz, o método traz vantagens computacionais. SDFT é aproximadamente quatro vezes mais lento e requer 2,5 vezes mais poder computacional (FLOPs) do que o ajuste fino padrão porque o modelo deve gerar ativamente suas próprias respostas (“rollouts”) durante o treinamento para comparar com o professor. No entanto, os investigadores observam que, como o modelo retém melhor o conhecimento, as organizações podem evitar os dispendiosos processos de reciclagem em várias fases, muitas vezes necessários para reparar modelos que sofrem de esquecimento catastrófico.

A técnica também depende do modelo subjacente ser grande o suficiente para se beneficiar do aprendizado no contexto. O artigo observa que modelos menores (por exemplo, 3 bilhões de parâmetros) inicialmente tiveram dificuldades porque não tinham a “inteligência” para agir como seus próprios professores.

No entanto, Shenfeld disse que a rápida melhoria dos modelos pequenos está mudando esta dinâmica. “Os modelos Qwen 2.5 3B eram muito fracos, mas em alguns experimentos que fazemos atualmente, descobrimos que o modelo Qwen 3 4B é forte o suficiente”, disse ele. “Vejo um futuro onde até mesmo os modelos 1B terão recursos ICL bons o suficiente para suportar SDFT.”

Em última análise, o objetivo é ir além dos instantâneos estáticos em direção a sistemas que melhoram com o uso.

“A aprendizagem ao longo da vida, juntamente com a capacidade de extrair sinais de aprendizagem de interações não estruturadas do usuário… trarão modelos que continuarão melhorando com o tempo”, disse Shenfeld.

“Pense no fato de que a maior parte da computação em todo o mundo já entra em inferência em vez de treinamento. Temos que encontrar maneiras de aproveitar essa computação para melhorar nossos modelos.”