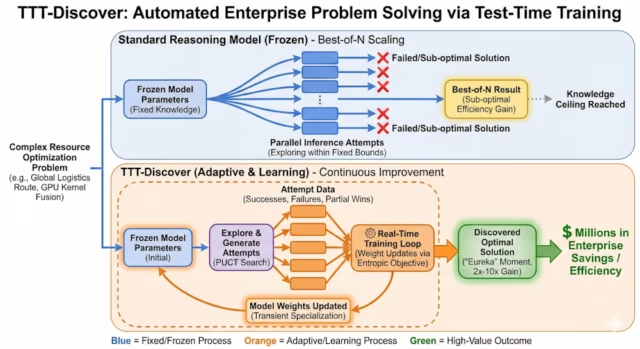

Pesquisadores de Stanford, Nvidia e Collectively AI desenvolveram uma nova técnica que pode descobrir novas soluções para problemas muito complexos. Por exemplo, eles conseguiram otimizar um kernel de GPU crítico para rodar 2x mais rápido do que o estado da arte anterior escrito por especialistas humanos.

Sua técnica, chamada “Treinamento em tempo de teste para descobrir“(TTT-Uncover), desafia o paradigma atual de deixar os modelos “pensarem mais” para problemas de raciocínio. O TTT-Uncover permite que o modelo proceed o treinamento durante o processo de inferência e atualize seus pesos para o problema em questão.

Os limites do raciocínio ‘congelado’

As estratégias atuais de IA empresarial muitas vezes dependem de modelos “congelados”. Quer você use um modelo de raciocínio fechado ou aberto, os parâmetros do modelo são estáticos. Quando você solicita esses modelos, eles procuram respostas na variedade fixa de seus dados de treinamento. Isso funciona bem para problemas que se assemelham ao que o modelo viu antes.

No entanto, os verdadeiros problemas de descoberta, como inventar um novo algoritmo ou provar um novo teorema matemático, estão, por definição, fora de distribuição. Se a solução exigir um salto de lógica que não existe no conjunto de treinamento, um modelo congelado provavelmente falhará, não importa quanta computação você jogue nele durante a inferência.

Em comentários ao VentureBeat, Mert Yuksekgonul, coautor do artigo e estudante de doutorado em Stanford, ilustrou essa distinção usando um famoso avanço matemático:

“Acredito que os modelos de pensamento não seriam capazes de provar, por exemplo, P! = NP, sem treinamento em tempo de teste, assim como Andrew Wiles não seria capaz de provar o Último Teorema de Fermat sem os 7 anos que passou perseguindo este único problema isoladamente e aprendendo continuamente com seus próprios fracassos.”

O TTT-Uncover trata o problema de teste não como uma consulta a ser respondida, mas como um ambiente a ser dominado. À medida que o modelo tenta resolver o problema, ele gera diferentes tipos de dados: falhas, sucessos parciais e erros. Em vez de descartar esses dados, o TTT-Uncover os utiliza para atualizar os pesos do modelo em tempo actual, permitindo efetivamente que o modelo se concentre naquele desafio específico, em vez de desenvolver uma estrutura muito geral de resolução de problemas.

Uma abordagem diferente para aprendizagem por reforço

O TTT-Uncover proporciona uma mudança elementary na forma como os modelos de raciocínio são treinados. No treinamento padrão de aprendizagem por reforço (RL), o objetivo é uma política generalista que tenha um bom desempenho, em média, em muitas tarefas. No TTT-Uncover, o objetivo é encontrar a melhor solução para um problema muito específico, e a política é “um meio para esse fim”, segundo os autores. Uma vez que o modelo descobre o artefato (ou seja, o código otimizado, a prova ou a molécula), a rede neural que o produziu pode ser descartada.

Para conseguir isso, os pesquisadores desenvolveram dois componentes específicos que diferenciam o TTT-Uncover da aprendizagem por reforço padrão:

-

Objetivo entrópico: RL padrão otimiza para a recompensa média esperada. Se um modelo tentar um caminho arriscado e falhar, o RL padrão o pune. TTT-Uncover inverte isso. Ele usa um “objetivo entrópico” que pesa exponencialmente os resultados de alta recompensa. Isto força o modelo a ignorar respostas “seguras” e médias e a procurar agressivamente valores discrepantes “eureka”, soluções que têm baixa probabilidade de serem encontradas, mas que oferecem uma recompensa enorme.

-

Pesquisa PUCT: O sistema apresenta PUCT, um algoritmo de busca em árvore inspirado em AlfaZero. Explora diferentes caminhos de solução, construindo um conjunto de dados de tentativas. O modelo então treina esse conjunto de dados em tempo actual, aprendendo a reconhecer quais etapas parciais levam a resultados de alta recompensa.

Crucialmente, este método funciona melhor em problemas com um sinal de recompensa contínuo. O sistema precisa de uma maneira de medir o progresso incremental, como “tempo de execução em microssegundos” ou “taxa de erro”, em vez de um sinal binário de “aprovado/reprovado”. Isso permite que o modelo siga a melhoria gradual em direção à solução ótima.

A economia da ‘inferência pesada’

Para empresas acostumadas a pagar frações de centavo por chamada de API, o perfil de custo do TTT-Uncover exige uma mudança de mentalidade. Em seus experimentos, os pesquisadores relataram que uma única execução de descoberta envolve aproximadamente 50 etapas de treinamento e milhares de implementações, custando cerca de US$ 500 por problema.

O TTT-Uncover poderia ser para “ativos estáticos e de alto valor”, em oposição a problemas triviais e recorrentes que podem ser resolvidos com modelos e abordagens existentes.

Considere uma empresa nativa da nuvem executando um pipeline de dados que processa petabytes de informações todas as noites. Se esse pipeline depender de uma consulta SQL específica ou de um kernel de GPU, otimizar esse código em apenas 1% poderia economizar centenas de milhares de dólares em custos anuais de computação. Nesse contexto, gastar US$ 500 para encontrar um kernel que seja 50% mais rápido é uma despesa trivial com um ROI imediato.

“Isso faz mais sentido para decisões de baixa frequência e alto impacto, onde uma única melhoria vale muito mais do que o custo computacional”, disse Yuksekgonul. “O roteamento da cadeia de suprimentos, o design de medicamentos e a descoberta de materiais são qualificados. Nesses ambientes, gastar centenas de dólares em uma única etapa de descoberta pode facilmente se pagar”.

Considerações de implementação

Uma das descobertas mais significativas para a adoção empresarial é que o TTT-Uncover não requer um modelo de fronteira proprietário. Os pesquisadores alcançaram resultados de última geração usando gpt-oss-120bmodelo de pesos abertos da OpenAI. Os pesquisadores têm liberou o código para o TTT-Uncover permitir que pesquisadores e desenvolvedores o utilizem em seus próprios modelos.

Como a técnica funciona com modelos abertos, as empresas podem executar esse “loop de descoberta” inteiramente dentro de seus próprios VPCs seguros ou clusters H100 locais, sem enviar seus dados proprietários a servidores de terceiros.

“Se uma empresa já administra aprendizado por reforço, não há necessidade de infraestrutura adicional”, disse Yuksekgonul. “O TTT-Uncover usa a mesma pilha de treinamento (GPUs, trabalhadores de implementação, otimizadores, pontos de verificação).”

Se ainda não administram a RL, precisariam construir essa infraestrutura. Mas as empresas também podem utilizar soluções existentes para reduzir a complexidade do processo. Os pesquisadores orquestraram essas execuções de treinamento usando o API de ajustes pela Considering Machines, uma API que gerencia a complexidade do treinamento e inferência distribuídos.

“Ferramentas como o Tinker (e variantes abertas, por exemplo, OpenTinker) reduzem o custo de configuração, e os custos de mão de obra e de computação provavelmente cairão com o tempo”, disse ele.

Casos de uso do mundo actual

Os pesquisadores implantaram o TTT-Uncover em quatro domínios técnicos distintos: engenharia de sistemas, design de algoritmos, biologia e matemática. Em quase todos os casos, o método estabeleceu um novo estado da arte.

Em um experimento, o modelo otimizou kernels de GPU para multiplicação de matrizes (incluindo o kernel “TriMul” usado em AlfaFold), alcançando velocidades de execução até 2x mais rápidas do que o estado da arte anterior e superando os melhores kernels escritos por humanos na tabela de classificação.

Em cenários de programação competitiva (AtCoder), resolveu problemas heurísticos complexos (por exemplo, otimização de restrições geométricas para redes de pesca) melhor do que os principais especialistas humanos e as linhas de base anteriores da IA.

Para a empresa, a transição destes referenciais académicos para o valor empresarial depende de uma restrição específica: a existência de um sinal escalar verificável. Ao contrário de um chatbot que gera texto, o TTT-Uncover precisa de uma métrica rígida (por exemplo, tempo de execução, taxa de erro ou margem de lucro) para otimizar.

Yuksekgonul disse que este requisito traça uma linha clara entre onde esta tecnologia deve e não deve ser usada. “No momento, o principal requisito é um sinal escalar confiável de progresso – custo, erro, propriedades moleculares – contra o qual o sistema possa otimizar”, disse ele.

Isso direciona a adoção empresarial para desafios “difíceis” de engenharia e operações, como logística, cadeia de suprimentos e gerenciamento de recursos, onde problemas como roteamento de frota ou agendamento de tripulação geralmente dependem de heurísticas estáticas. O TTT-Uncover pode tratá-los como ambientes de otimização, gastando horas para encontrar uma estrutura de rota que reduza em 5% os custos diários de combustível.

A exigência de verificadores claros exclui tarefas qualitativas como “escrever uma estratégia de advertising and marketing melhor”, onde a verificação é subjetiva e propensa a ruídos.

“Problemas difíceis de verificar ainda são uma questão em aberto”, disse Yuksekgonul.

Com a tecnologia atual, o melhor caminho a seguir é tentar projetar verificadores, mas “tornar esses verificadores robustos e difíceis de manipular é um desafio, e ainda não temos uma boa solução”, acrescentou.

Da inferência à invenção

A implicação mais ampla é que as pilhas de IA empresarial podem precisar evoluir para apoiar esse tipo de aprendizagem por problema.

“Os sistemas construídos em torno de um modelo congelado precisarão suportar a adaptação por problema (ou por domínio), e as empresas precisarão de melhores especificações de problemas e sinais de suggestions interno para tornar eficaz o aprendizado em tempo de teste”, disse Yuksekgonul. “Se o treinamento for executado dentro de uma VPC privada, o ciclo de treinamento também poderá ser integrado com mais ambientes internos da empresa, e não apenas com um pipeline de laboratório central.”

Para a empresa, o valor reside na identificação de “problemas de milhões de dólares”, desafios de otimização onde existe uma métrica verificável, mas o progresso humano estagnou. Estes são os candidatos ao TTT-Uncover. Ao aceitar maior latência e custo para consultas específicas, as empresas podem transformar sua computação de inferência em um laboratório automatizado de P&D, descobrindo soluções que antes estavam fora do alcance tanto de humanos quanto de modelos de IA congelados.