A equipe Qwen de pesquisadores de IA da gigante chinesa de comércio eletrônico Alibaba emergiu no ano passado como um dos líderes globais no desenvolvimento de IA de código aberto, lançando uma série de poderosos modelos de linguagem grande e modelos multimodais especializados que se aproximam e, em alguns casos, superam o desempenho dos líderes proprietários dos EUA, como OpenAI, Anthropic, Google e xAI.

Agora a equipe Qwen está de volta esta semana com um lançamento atraente que corresponde ao frenesi de “vibe coding” que surgiu nos últimos meses: Qwen3-Coder-Próximoum modelo especializado de 80 bilhões de parâmetros projetado para oferecer desempenho de agente de elite em uma área ativa leve.

Foi lançado com uma licença permissiva Apache 2.0, permitindo o uso comercial por grandes empresas e desenvolvedores independentes, com o pesos de modelo disponíveis no Hugging Face em quatro variantes e um relatório técnico descrevendo algumas de suas abordagens e inovações de treinamento.

O lançamento marca uma grande escalada na corrida armamentista international pelo assistente de codificação definitivo, após uma semana em que o espaço explodiu com novos participantes. Desde os enormes ganhos de eficiência do equipamento Claude Code da Anthropic até o lançamento de alto nível do aplicativo OpenAI Codex e a rápida adoção pela comunidade de estruturas de código aberto como o OpenClaw, o cenário competitivo nunca foi tão concorrido.

Neste ambiente de alto risco, a Alibaba não está apenas a acompanhar o ritmo – está a tentar estabelecer um novo padrão para a inteligência aberta.

Para os tomadores de decisão do LLM, o Qwen3-Coder-Subsequent representa uma mudança elementary na economia da engenharia de IA. Embora o modelo abrigue 80 bilhões de parâmetros totais, ele utiliza uma arquitetura ultra-esparsa de Mistura de Especialistas (MoE) que ativa apenas 3 bilhões de parâmetros por passagem direta.

Esse design permite fornecer recursos de raciocínio que rivalizam com sistemas proprietários massivos, ao mesmo tempo em que mantém os baixos custos de implantação e o alto rendimento de um modelo native leve.

Resolvendo o gargalo de longo contexto

O principal avanço técnico por trás do Qwen3-Coder-Subsequent é uma arquitetura híbrida projetada especificamente para contornar os problemas de escala quadrática que afetam os Transformers tradicionais.

À medida que as janelas de contexto se expandem – e este modelo suporta 262.144 tokens – os mecanismos tradicionais de atenção tornam-se computacionalmente proibitivos.

Os transformadores padrão sofrem de uma “parede de memória”, onde o custo do contexto de processamento cresce quadraticamente com o comprimento da sequência. Qwen resolve isso combinando Gated DeltaNet com Gated Consideration.

Gated DeltaNet atua como uma alternativa de complexidade linear à atenção softmax padrão. Ele permite que o modelo mantenha o estado em sua janela de um quarto de milhão de tokens sem as penalidades de latência exponenciais típicas do raciocínio de longo horizonte.

Quando combinado com o MoE ultraesparso, o resultado é um rendimento teórico 10x maior para tarefas em nível de repositório em comparação com modelos densos de capacidade complete semelhante.

Essa arquitetura garante que um agente possa “ler” uma biblioteca Python inteira ou uma estrutura JavaScript complexa e responder com a velocidade de um modelo 3B, mas com o entendimento estrutural de um sistema 80B.

Para evitar alucinações de contexto durante o treinamento, a equipe utilizou o Greatest-Match Packing (BFP), uma estratégia que mantém a eficiência sem os erros de truncamento encontrados na concatenação tradicional de documentos.

Treinado para ser o agente em primeiro lugar

O “Próximo” na nomenclatura do modelo refere-se a um pivô elementary na metodologia de treinamento. Historicamente, os modelos de codificação eram treinados em pares de código-texto estáticos – essencialmente uma educação “somente leitura”. Em vez disso, o Qwen3-Coder-Subsequent foi desenvolvido por meio de um enorme pipeline de “treinamento de agentes”.

O relatório técnico detalha um pipeline de síntese que produziu 800.000 tarefas de codificação verificáveis. Estes não eram meros fragmentos; eram cenários de correção de bugs do mundo actual extraídos de solicitações pull do GitHub e emparelhados com ambientes totalmente executáveis.

A infraestrutura de treinamento, conhecida como MegaFlow, é um sistema de orquestração nativo da nuvem baseado no Alibaba Cloud Kubernetes. No MegaFlow, cada tarefa do agente é expressa como um fluxo de trabalho de três estágios: implementação do agente, avaliação e pós-processamento. Durante a implementação, o modelo interage com um ambiente em contêiner ativo.

Se ele gerar código que falhe em um teste de unidade ou trave um contêiner, ele receberá suggestions imediato por meio do treinamento intermediário e do aprendizado por reforço. Essa educação em “circuito fechado” permite que o modelo aprenda com o suggestions do ambiente, ensinando-o a se recuperar de falhas e a refinar soluções em tempo actual.

As especificações do produto incluem:

-

Suporte para 370 linguagens de programação: Uma expansão de 92 nas versões anteriores.

-

Chamada de ferramenta estilo XML: Um novo formato qwen3_coder projetado para argumentos com muitas strings, permitindo que o modelo emita longos trechos de código sem aspas aninhadas e a sobrecarga de escape típica do JSON.

-

Foco no nível do repositório: O treinamento intermediário foi expandido para aproximadamente 600 bilhões de tokens de dados em nível de repositório, provando ser mais impactante para a lógica de dependência entre arquivos do que apenas para conjuntos de dados em nível de arquivo.

Especialização through modelos especialistas

Um diferencial importante no pipeline Qwen3-Coder-Subsequent é o uso de modelos especializados especializados. Em vez de treinar um modelo generalista para todas as tarefas, a equipe desenvolveu especialistas específicos de domínio para Desenvolvimento Net e Experiência do Usuário (UX).

O Net Improvement Professional tem como alvo tarefas full-stack, como construção de UI e composição de componentes. Todos os exemplos de código foram renderizados em um ambiente Chromium controlado pelo Playwright.

Para amostras do React, um servidor Vite foi implantado para garantir que todas as dependências foram inicializadas corretamente. Um modelo de linguagem de visão (VLM) julgou as páginas renderizadas quanto à integridade do format e qualidade da interface do usuário.

O Consumer Expertise Professional foi otimizado para aderência ao formato de chamada de ferramenta em diversos scaffolds CLI/IDE, como Cline e OpenCode. A equipe descobriu que o treinamento em diversos modelos de chat de ferramentas melhorou significativamente a robustez do modelo para esquemas invisíveis no momento da implantação.

Depois que esses especialistas atingiram o desempenho máximo, suas capacidades foram destiladas de volta ao modelo único 80B/3B MoE. Isso garante que a versão de implantação leve retenha o conhecimento diferenciado de modelos de professores muito maiores.

Melhorando os benchmarks e oferecendo alta segurança

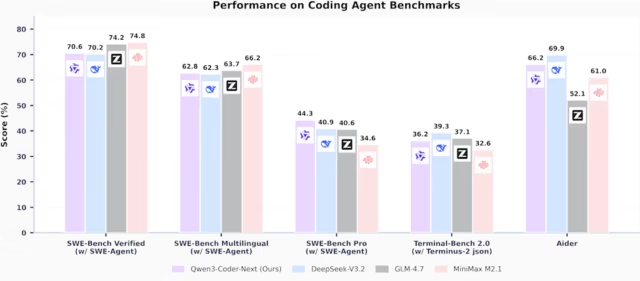

Os resultados dessa formação especializada ficam evidentes na posição competitiva do modelo frente aos gigantes do setor. Em avaliações de benchmark realizadas usando a estrutura SWE-Agent, o Qwen3-Coder-Subsequent demonstrou eficiência excepcional em relação à sua contagem de parâmetros ativos.

No SWE-Bench Verified, o modelo alcançou pontuação de 70,6%. Este desempenho é notavelmente competitivo quando colocado ao lado de modelos significativamente maiores; ele supera o DeepSeek-V3.2, que pontua 70,2%, e fica apenas um pouco atrás da pontuação de 74,2% do GLM-4.7.

Crucialmente, o modelo demonstra uma sólida consciência de segurança inerente. No SecCodeBench, que avalia a capacidade de um modelo de reparar vulnerabilidades, o Qwen3-Coder-Subsequent superou o Claude-Opus-4.5 em cenários de geração de código (61,2% vs. 52,5%).

Notavelmente, manteve pontuações altas mesmo quando não recebeu nenhuma dica de segurança, indicando que aprendeu a antecipar armadilhas de segurança comuns durante a fase de treinamento de agentes de 800 mil tarefas.

Em avaliações de segurança multilíngues, o modelo também demonstrou um equilíbrio competitivo entre geração de código funcional e seguro, superando DeepSeek-V3.2 e GLM-4.7 no benchmark CWEval com uma pontuação func-sec@1 de 56,32%.

Desafiando os gigantes proprietários

O lançamento representa o desafio mais significativo ao domínio dos modelos de codificação de código fechado em 2026. Ao provar que um modelo com apenas 3B de parâmetros ativos pode navegar pelas complexidades da engenharia de software program do mundo actual tão eficazmente quanto um “gigante”, o Alibaba democratizou efetivamente a codificação de agentes.

O “ahá!” O momento para a indústria é a constatação de que a extensão e a taxa de transferência do contexto são as duas alavancas mais importantes para o sucesso da agência.

Um modelo que pode processar 262 mil tokens de um repositório em segundos e verificar seu próprio trabalho em um contêiner Docker é fundamentalmente mais útil do que um modelo maior que é muito lento ou caro para iterar.

Como a equipe Qwen conclui em seu relatório: “Escalar o treinamento do agente, em vez de apenas o tamanho do modelo, é um fator chave para o avanço da capacidade do agente de codificação no mundo actual”. Com o Qwen3-Coder-Subsequent, a period do modelo de codificação “gigantesco” pode estar chegando ao fim, substituída por especialistas esparsos e ultrarrápidos que podem pensar tão profundamente quanto podem executar.