Um novo estudo do Google sugere que modelos de raciocínio avançados alcançam alto desempenho ao simular debates do tipo multiagentes envolvendo diversas perspectivas, traços de personalidade e conhecimentos de domínio.

As suas experiências demonstram que este debate interno, que eles apelidam de “sociedade do pensamento“, melhora significativamente o desempenho do modelo em tarefas complexas de raciocínio e planejamento. Os pesquisadores descobriram que os principais modelos de raciocínio, como DeepSeek-R1 e QwQ-32B, que são treinados through aprendizagem por reforço (RL), desenvolvem inerentemente essa capacidade de se envolver em conversas em sociedade de pensamentos sem instrução explícita.

Essas descobertas oferecem um roteiro sobre como os desenvolvedores podem construir aplicativos LLM mais robustos e como as empresas podem treinar modelos superiores usando seus próprios dados internos.

O que é a sociedade do pensamento?

A premissa central da sociedade do pensamento é que os modelos de raciocínio aprendem a emular diálogos sociais multiagentes para refinar a sua lógica. Esta hipótese baseia-se na ciência cognitiva, especificamente na ideia de que a razão humana evoluiu principalmente como um processo social para resolver problemas através da argumentação e do envolvimento com diferentes pontos de vista.

Os pesquisadores escrevem que “a diversidade cognitiva, decorrente da variação nas competências e nos traços de personalidade, melhora a resolução de problemas, especialmente quando acompanhada por dissidência autêntica”. Consequentemente, sugerem que a integração de diversas perspectivas permite aos LLM desenvolver estratégias de raciocínio robustas. Ao simular conversas entre diferentes personas internas, os modelos podem realizar verificações essenciais (como verificação e retrocesso) que ajudam a evitar armadilhas comuns, como preconceitos indesejados e bajulação.

Em modelos como o DeepSeek-R1, essa “sociedade” se manifesta diretamente na cadeia de pensamento. Os pesquisadores observam que não são necessários modelos ou prompts separados para forçar essa interação; o debate emerge de forma autônoma dentro do processo de raciocínio de uma única instância modelo.

Exemplos de sociedade de pensamento

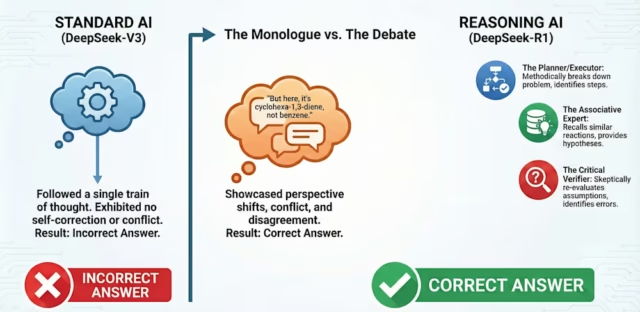

O estudo fornece exemplos tangíveis de como esse atrito interno leva a melhores resultados. Em um experimento envolvendo um problema complexo de síntese de química orgânica, DeepSeek-R1 simulou um debate entre múltiplas perspectivas internas distintas, incluindo um “Planejador” e um “Verificador Crítico”.

O Planejador propôs inicialmente uma through de reação padrão. No entanto, o Verificador Crítico (caracterizado como tendo alta consciência e baixa agradabilidade) interrompeu para desafiar a suposição e forneceu um contra-argumento com novos fatos. Através desta verificação adversa, o modelo descobriu o erro, reconciliou as visões conflitantes e corrigiu o caminho de síntese.

Uma dinâmica semelhante apareceu nas tarefas criativas. Quando solicitado a reescrever a frase “Joguei meu ódio no fogo ardente”, o modelo simulou uma negociação entre um “Ideador Criativo” e um “Verificador de Fidelidade Semântica”. Depois que o idealizador sugeriu uma versão usando a palavra “profundamente arraigado”, o verificador respondeu: “Mas isso acrescenta ‘profundamente arraigado’, o que não estava no authentic. Devemos evitar adicionar novas ideias.” O modelo acabou por chegar a um compromisso que manteve o significado authentic ao mesmo tempo que melhorou o estilo.

Talvez a evolução mais marcante tenha ocorrido no “Jogo da Contagem Regressiva”, um quebra-cabeça matemático em que o modelo deve usar números específicos para atingir um valor-alvo. No início do treinamento, o modelo tentou resolver o problema usando uma abordagem monóloga. Como aprendeu through RL, ele se dividiu espontaneamente em duas personas distintas: um “Solucionador de Problemas Metódico” realizando cálculos e um “Pensador Exploratório” monitorando o progresso, que interromperia caminhos fracassados com comentários como “Mais uma vez sem sorte… Talvez possamos tentar usar números negativos”, levando o Solucionador Metódico a mudar de estratégia.

Estas descobertas desafiam a suposição de que cadeias de pensamento mais longas resultam automaticamente em maior precisão. Em vez disso, comportamentos diversos, como observar as respostas através de lentes diferentes, verificar suposições anteriores, retroceder e explorar alternativas, impulsionam as melhorias no raciocínio. Os pesquisadores reforçaram isso ao direcionar artificialmente o espaço de ativação de um modelo para desencadear surpresa na conversa; esta intervenção ativou uma gama mais ampla de recursos relacionados à personalidade e à experiência, duplicando a precisão em tarefas complexas.

A implicação é que o raciocínio social emerge autonomamente através da VR em função do impulso do modelo para produzir respostas corretas, e não através da supervisão humana explícita. Na verdade, os modelos de treinamento em monólogos tiveram desempenho inferior ao RL bruto, que naturalmente desenvolveu conversas multiagentes. Por outro lado, realizar ajuste fino supervisionado (SFT) em conversas multipartidárias e debate superou significativamente o desempenho do SFT em cadeias de pensamento padrão.

Implicações para IA empresarial

Para desenvolvedores e tomadores de decisão empresariais, esses insights oferecem diretrizes práticas para a construção de aplicações de IA mais poderosas.

Engenharia imediata para ‘conflito’

Os desenvolvedores podem aprimorar o raciocínio em modelos de uso geral, solicitando-os explicitamente a adotar uma estrutura de sociedade de pensamento. Porém, não basta simplesmente pedir à modelo para conversar consigo mesma.

“Não basta ‘ter um debate’, mas ter diferentes pontos de vista e disposições que tornem o debate inevitável e permitam que esse debate discover e discrimine entre alternativas”, disse James Evans, co-autor do artigo, ao VentureBeat.

Em vez de funções genéricas, os desenvolvedores devem criar instruções que atribuam disposições opostas (por exemplo, um responsável pela conformidade avesso ao risco versus um gestor de produto focado no crescimento) para forçar o modelo a discriminar entre alternativas. Mesmo dicas simples que orientam o modelo para expressar “surpresa” podem desencadear esses caminhos de raciocínio superiores.

Design para escala social

À medida que os desenvolvedores dimensionam a computação do tempo de teste para permitir que os modelos “pensem” por mais tempo, eles devem estruturar esse tempo como um processo social. As aplicações devem facilitar um processo “social” onde o modelo usa pronomes como “nós”, faz perguntas a si mesmo e debate explicitamente alternativas antes de convergir para uma resposta.

Esta abordagem também pode expandir-se para sistemas multiagentes, onde personalidades distintas atribuídas a diferentes agentes se envolvem em debates críticos para chegar a melhores decisões.

Pare de limpar seus dados de treinamento

Talvez a implicação mais significativa resida na forma como as empresas treinam ou aperfeiçoam os seus próprios modelos. Tradicionalmente, as equipes de dados limpam seus conjuntos de dados para criar “Respostas de Ouro” que fornecem caminhos lineares perfeitos para uma solução. O estudo sugere que isso pode ser um erro.

Modelos ajustados com base em dados de conversação (por exemplo, transcrições de debates e resoluções entre vários agentes) melhoram o raciocínio significativamente mais rápido do que aqueles treinados em monólogos claros. Há até valor em debates que não levam à resposta correta.

“Treinamos em andaimes de conversação que levaram à resposta errada, depois reforçamos o modelo e descobrimos que ele funcionava tão bem quanto reforçava a resposta certa, sugerindo que os hábitos de conversação de explorar soluções eram os mais importantes para novos problemas”, disse Evans.

Isso implica que as empresas devem parar de descartar logs de engenharia “confusos” ou threads do Slack onde os problemas foram resolvidos iterativamente. A “bagunça” é onde o modelo aprende o hábito da exploração.

Expondo a ‘caixa preta’ para confiança e auditoria

Para casos de uso corporativo de alto risco, simplesmente obter uma resposta não é suficiente. Evans argumenta que os usuários precisam ver a dissidência interna para confiar no resultado, sugerindo uma mudança no design da interface do usuário.

“Precisamos de uma nova interface que nos exponha sistematicamente os debates internos para que possamos ‘participar’ na calibração da resposta certa”, disse Evans. “Nós nos saímos melhor com o debate; as IAs se saem melhor com o debate; e nós nos saímos melhor quando expostos ao debate da IA.”

O caso estratégico para pesos abertos

Essas descobertas fornecem um novo argumento no debate “construir versus comprar” em relação a modelos abertos versus APIs proprietárias. Muitos modelos de raciocínio proprietários escondem a sua cadeia de pensamento, tratando o debate interno como um segredo comercial ou uma responsabilidade de segurança.

Mas Evans argumenta que “ninguém apresentou realmente uma justificação para expor esta sociedade de pensamento antes”, mas que o valor de auditar estes conflitos internos está a tornar-se inegável. Até que os fornecedores proprietários ofereçam whole transparência, as empresas em sectores de elevada conformidade poderão descobrir que os modelos de peso aberto oferecem uma vantagem distinta: a capacidade de ver a dissidência, e não apenas a decisão.

“Acredito que grandes modelos proprietários começarão a servir (e licenciar) as informações assim que perceberem que há valor nelas”, disse Evans.

A pesquisa sugere que o trabalho de um arquiteto de IA está mudando do puro treinamento de modelos para algo mais próximo da psicologia organizacional.

“Acredito que isto abre toda uma nova fronteira de pequenos grupos e design organizacional dentro e entre modelos que provavelmente permitirá novas lessons de desempenho”, disse Evans. “Minha equipe está trabalhando nisso e espero que outros também estejam.”