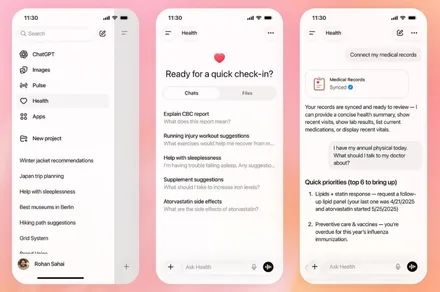

No início deste mês, a OpenAI introduziu um novo espaço focado na saúde dentro do ChatGPT, apresentando-o como uma maneira mais segura para os usuários fazerem perguntas sobre tópicos delicados, como dados médicos, doenças e condicionamento físico. Um dos principais recursos destacados no lançamento foi a capacidade do ChatGPT Well being de analisar dados de aplicativos como Apple Well being, MyFitnessPal e Peloton para revelar tendências de longo prazo e fornecer resultados personalizados. No entanto, um novo relatório sugere que a OpenAI pode ter exagerado a eficácia do recurso na obtenção de insights confiáveis a partir desses dados.

De acordo com os primeiros testes realizados por O Washington PostGeoffrey A. Fowler, quando o ChatGPT Well being teve acesso a dados de uma década de Apple Well being, o chatbot classificou a saúde cardíaca do repórter como F. No entanto, depois de analisar a avaliação, um cardiologista a chamou de “infundada” e disse que o risco actual de doença cardíaca do repórter period extremamente baixo.

Eric Topol, do Scripps Analysis Institute, fez uma avaliação contundente das capacidades do ChatGPT Well being, dizendo que a ferramenta não está pronta para oferecer aconselhamento médico e depende muito de métricas não confiáveis de smartwatch. A nota do ChatGPT baseou-se fortemente nas estimativas do Apple Watch de VO2 máximo e variabilidade da frequência cardíaca, ambas com limitações conhecidas e podem variar significativamente entre dispositivos e versões de software program. Uma pesquisa independente descobriu que as estimativas de VO2 máximo do Apple Watch geralmente são baixas, mas o ChatGPT ainda as trata como indicadores claros de problemas de saúde.

ChatGPT Well being deu notas diferentes para os mesmos dados

Os problemas não pararam por aí. Quando o repórter pediu ao ChatGPT Well being para repetir o mesmo exercício de classificação, a pontuação oscilou entre F e B nas conversas, com o chatbot às vezes ignorando relatórios recentes de exames de sangue aos quais teve acesso e ocasionalmente esquecendo detalhes básicos como idade e sexo do repórter. Claude for Healthcare, da Anthropic, que também estreou no início deste mês, mostrou consistências semelhantes, atribuindo notas que variavam entre C e B menos.

Tanto a OpenAI quanto a Anthropic enfatizaram que suas ferramentas não se destinam a substituir os médicos e apenas fornecer um contexto geral. Ainda assim, ambos os chatbots forneceram avaliações confiáveis e altamente personalizadas da saúde cardiovascular. Esta combinação de autoridade e inconsistência poderia assustar os usuários saudáveis ou tranquilizar falsamente os não saudáveis. Embora a IA possa eventualmente desbloquear informações valiosas a partir de dados de saúde a longo prazo, os primeiros testes sugerem que alimentar anos de dados de monitorização de health nestas ferramentas cria atualmente mais confusão do que clareza.