As empresas chinesas de IA e tecnologia continuam a impressionar com o desenvolvimento de modelos de linguagem de IA de última geração.

Hoje, quem chama a atenção é a equipe Qwen de pesquisadores de IA da Alibaba Cloud e a revelação de um novo modelo de raciocínio de linguagem proprietário, Qwen3-Max-Pensando.

Você deve se lembrar, como a VentureBeat cobriu no ano passado, que Qwen fez seu nome no mercado world de IA em rápida evolução, fornecendo uma variedade de modelos poderosos e de código aberto em várias modalidades, de texto a imagem e áudio falado. A empresa até ganhou o endosso da gigante norte-americana de hospedagem de tecnologia Airbnb, cujo CEO e cofundador Brian Chesky disse que a empresa estava confiando nos modelos gratuitos e de código aberto de Qwen como uma alternativa mais acessível às ofertas dos EUA, como as da OpenAI.

Agora, com o Qwen3-Max-Pondering proprietário, a equipe Qwen pretende igualar e, em alguns casos, superar as capacidades de raciocínio do GPT-5.2 e Gemini 3 Professional por meio de eficiência arquitetônica e autonomia de agente.

O lançamento chega em um momento crítico. Os laboratórios ocidentais definiram amplamente a categoria de “raciocínio” (muitas vezes apelidada de lógica do “Sistema 2”), mas os últimos benchmarks de Qwen sugerem que a lacuna foi eliminada.

Além disso, o preço relativamente acessível da empresa Estratégia de preços de API visa agressivamente a adoção empresarial. No entanto, como se trata de um modelo chinês, algumas empresas norte-americanas com requisitos e considerações estritas de segurança nacional podem ter receio de adotá-lo.

A Arquitetura: “Escala de Tempo de Teste” Redefinida

A principal inovação que impulsiona o Qwen3-Max-Pondering é um afastamento dos métodos de inferência padrão. Embora a maioria dos modelos gere tokens linearmente, o Qwen3 utiliza um “modo pesado” conduzido por uma técnica conhecida como “escalonamento em tempo de teste”.

Em termos simples, esta técnica permite que o modelo troque computação por inteligência. Mas, ao contrário da amostragem ingênua do tipo “melhor de N” – onde um modelo pode gerar 100 respostas e escolher a melhor – o Qwen3-Max-Pondering emprega uma estratégia multi-rodada de experiência cumulativa.

Essa abordagem imita a resolução humana de problemas. Quando o modelo encontra uma consulta complexa, ele não apenas adivinha; ele se envolve em autorreflexão iterativa. Ele usa um mecanismo proprietário de “experiência” para destilar insights de etapas de raciocínio anteriores. Isso permite que o modelo:

-

Identifique becos sem saída: Reconheça quando uma linha de raciocínio está falhando sem precisar percorrê-la completamente.

-

Computação de foco: Redirecione o poder de processamento para “incertezas não resolvidas” em vez de derivar novamente conclusões conhecidas.

Os ganhos de eficiência são tangíveis. Ao evitar raciocínios redundantes, o modelo integra um contexto histórico mais rico na mesma janela. A equipe Qwen relata que esse método gerou grandes saltos de desempenho sem explodir os custos de token:

Além do pensamento puro: ferramentas adaptativas

Embora os modelos de “pensamento” sejam poderosos, eles têm sido historicamente isolados – ótimos em matemática, mas ruins em navegar na net ou executar código. Qwen3-Max-Pondering preenche essa lacuna integrando efetivamente os “modos de pensar e não pensar”.

O modelo apresenta recursos adaptativos de uso de ferramentas, o que significa que seleciona de forma autônoma a ferramenta certa para o trabalho, sem necessidade de solicitação guide do usuário. Ele pode alternar perfeitamente entre:

-

Pesquisa e extração na Internet: Para consultas factuais em tempo actual.

-

Memória: Para armazenar e recuperar o contexto específico do usuário.

-

Intérprete de código: Escrever e executar snippets Python para tarefas computacionais.

No “Modo de Pensamento”, o modelo oferece suporte a essas ferramentas simultaneamente. Esse recurso é basic para aplicativos corporativos onde um modelo pode precisar verificar um fato (Pesquisa), calcular uma projeção (Interpretador de Código) e então raciocinar sobre a implicação estratégica (Pensamento), tudo de uma vez.

Empiricamente, a equipa observa que esta combinação “mitiga eficazmente as alucinações”, uma vez que o modelo pode basear o seu raciocínio em dados externos verificáveis, em vez de confiar apenas nos seus pesos de treino.

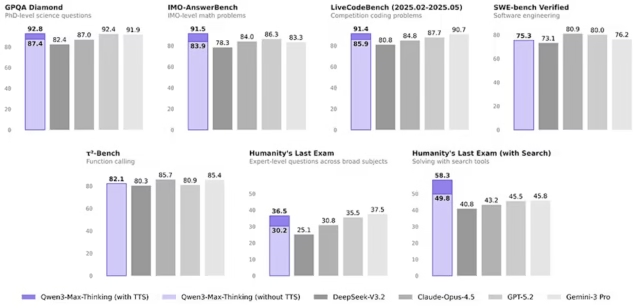

Análise de benchmark: a história dos dados

Qwen não tem vergonha de comparações diretas.

No HMMT de 25 de fevereiro, um benchmark de raciocínio rigoroso, Qwen3-Max-Pondering obteve pontuação de 98,0, superando o Gemini 3 Professional (97,5) e liderando significativamente o DeepSeek V3.2 (92,5).

No entanto, o sinal mais significativo para os desenvolvedores é, sem dúvida, o Agentic Search. No “Último Exame da Humanidade” (HLE) – o benchmark que mede o desempenho em 3.000 questões de pós-graduação “à prova do Google” em matemática, ciências, ciência da computação, humanidades e engenharia – Qwen3-Max-Pondering, equipado com ferramentas de pesquisa na net, obteve pontuação de 49,8, superando Gemini 3 Professional (45,8) e GPT-5.2-Pondering (45,5) .

Isso sugere que a arquitetura do Qwen3-Max-Pondering é especialmente adequada para fluxos de trabalho de agência complexos e de várias etapas, onde a recuperação externa de dados é necessária.

Nas tarefas de codificação, o modelo também brilha. No Enviornment-Laborious v2, obteve uma pontuação de 90,2, deixando concorrentes como Claude-Opus-4,5 (76,7) para trás.

A Economia do Raciocínio: Análise de Preços

Pela primeira vez, temos uma visão clara da economia do modelo de raciocínio de nível superior de Qwen. Alibaba Cloud posicionou-se qwen3-max-2026-01-23 como uma oferta premium, mas acessível em sua API.

Em um nível básico, veja como o Qwen3-Max-Pondering se compara:

|

Modelo |

Entrada (/1M) |

Saída (/1M) |

Custo complete |

Fonte |

|

Qwen3 Turbo |

US$ 0,05 |

US$ 0,20 |

US$ 0,25 |

|

|

Grok 4.1 Rápido (raciocínio) |

US$ 0,20 |

US$ 0,50 |

US$ 0,70 |

|

|

Grok 4.1 Rápido (sem raciocínio) |

US$ 0,20 |

US$ 0,50 |

US$ 0,70 |

|

|

deepseek-chat (V3.2-Exp) |

US$ 0,28 |

US$ 0,42 |

US$ 0,70 |

|

|

raciocinador de busca profunda (V3.2-Exp) |

US$ 0,28 |

US$ 0,42 |

US$ 0,70 |

|

|

Qwen 3 Plus |

US$ 0,40 |

US$ 1,20 |

US$ 1,60 |

|

|

ERNIE 5.0 |

US$ 0,85 |

US$ 3,40 |

US$ 4,25 |

|

|

Pré-visualização em Flash do Gêmeos 3 |

US$ 0,50 |

US$ 3,00 |

US$ 3,50 |

|

|

Claude Haiku 4.5 |

US$ 1,00 |

US$ 5,00 |

US$ 6,00 |

|

|

Pensamento Qwen3-Max (23/01/2026) |

US$ 1,20 |

US$ 6,00 |

US$ 7,20 |

|

|

Gêmeos 3 Professional (≤200K) |

US$ 2,00 |

US$ 12,00 |

US$ 14,00 |

|

|

GPT-5.2 |

US$ 1,75 |

US$ 14,00 |

US$ 15,75 |

|

|

Soneto de Claude 4.5 |

US$ 3,00 |

US$ 15,00 |

US$ 18,00 |

|

|

Gêmeos 3 Professional (>200K) |

US$ 4,00 |

US$ 18,00 |

US$ 22,00 |

|

|

Claude Opus 4.5 |

US$ 5,00 |

US$ 25,00 |

US$ 30,00 |

|

|

GPT-5.2 Pró |

US$ 21,00 |

US$ 168,00 |

US$ 189,00 |

Esta estrutura de preços é agressiva, prejudicando muitos modelos emblemáticos legados, ao mesmo tempo que oferece desempenho de última geração.

No entanto, os desenvolvedores devem observar o preço granular dos novos recursos de agente, já que Qwen separa o custo de “pensar” (tokens) do custo de “fazer” (uso de ferramentas).

-

Estratégia de busca de agentes: Ambos padrão

search_strategy:agente quanto mais avançadosearch_strategy:agent_maxcustam US$ 10 por 1.000 chamadas. -

Pesquisa na Internet: Custa US$ 10 por 1.000 chamadas por meio da API Responses.

Nível promocional gratuito:Para incentivar a adoção de seus recursos mais avançados, o Alibaba Cloud oferece atualmente duas ferramentas principais gratuitamente por tempo limitado:

Este modelo de preços (baixo custo de token + preços de ferramentas à la carte) permite que os desenvolvedores criem agentes complexos que são econômicos para processamento de texto, ao mesmo tempo que pagam um prêmio apenas quando ações externas – como uma pesquisa na net ao vivo – são explicitamente acionadas.

Ecossistema de Desenvolvedores

Reconhecendo que o desempenho é inútil sem integração, a Alibaba Cloud garantiu que o Qwen3-Max-Pondering esteja pronto para uso.

-

Compatibilidade OpenAI: A API suporta o formato OpenAI padrão, permitindo que as equipes troquem de modelo simplesmente alterando o

base_urlemannequinnome. -

Compatibilidade Antrópica: Em um movimento inteligente para capturar o mercado de codificação, a API também oferece suporte ao protocolo Antrópico. Isso torna o Qwen3-Max-Pondering compatível com Código Claudeum ambiente de codificação agente fashionable.

O veredicto

Qwen3-Max-Pondering representa um amadurecimento do mercado de IA em 2026. Ele transfer a conversa além de “quem tem o chatbot mais inteligente” para “quem tem o agente mais capaz”.

Ao combinar o raciocínio de alta eficiência com o uso adaptativo e autônomo de ferramentas – e definir o preço para sua movimentação – Qwen se estabeleceu firmemente como um candidato de primeira linha ao trono da IA corporativa.

Para desenvolvedores e empresas, as janelas “Restricted Time Free” no Code Interpreter e Internet Extractor sugerem que agora é a hora de experimentar. As guerras de raciocínio estão longe de terminar, mas Qwen acaba de implantar um rebatedor muito pesado.