Uma nova técnica desenvolvida por pesquisadores da Universidade Jiao Tong de Xangai e de outras instituições permite que grandes agentes de modelos linguísticos aprendam novas habilidades sem a necessidade de ajustes caros.

Os pesquisadores propõem MemRLuma estrutura que dá aos agentes a capacidade de desenvolver memória episódica, a capacidade de recuperar experiências passadas para criar soluções para tarefas invisíveis. MemRL permite que os agentes usem suggestions ambiental para refinar continuamente suas estratégias de resolução de problemas.

MemRL faz parte de um esforço mais amplo na comunidade de pesquisa para desenvolver aprendizagem contínua capacidades para aplicações de IA. Em experimentos nos principais benchmarks do setor, a estrutura superou outras linhas de base, como RAG e outras técnicas de organização de memória, especialmente em ambientes complexos que exigem exploração e experimentos. Isto sugere que o MemRL pode se tornar um componente crítico para a construção de aplicações de IA que devem operar em ambientes dinâmicos do mundo actual, onde os requisitos e tarefas mudam constantemente.

O dilema estabilidade-plasticidade

Um dos desafios centrais na implantação de aplicações agênticas é a adaptação do modelo subjacente a novos conhecimentos e tarefas após a fase inicial de treinamento. As abordagens atuais geralmente se enquadram em duas categorias: abordagens paramétricas, como afinaçãoe abordagens não paramétricas, como RAG. Mas ambos trazem compensações significativas.

O ajuste fino, embora eficaz para incorporar novas informações, é computacionalmente caro e lento. Mais criticamente, muitas vezes leva a esquecimento catastróficoum fenômeno em que o conhecimento recém-adquirido substitui os dados aprendidos anteriormente, degradando o desempenho geral do modelo.

Por outro lado, métodos não paramétricos como RAG são fundamentalmente passivos; eles recuperam informações com base apenas na similaridade semântica, como incorporações de vetores, sem avaliar a utilidade actual das informações para a consulta de entrada. Esta abordagem pressupõe que “semelhante implica útil”, o que muitas vezes é falho em tarefas de raciocínio complexas.

Os investigadores argumentam que a inteligência humana resolve este problema mantendo “o delicado equilíbrio entre a estabilidade do raciocínio cognitivo e a plasticidade da memória episódica”. No cérebro humano, o raciocínio estável (associado ao córtex) está dissociado da memória episódica dinâmica. Isso permite que os humanos se adaptem a novas tarefas sem “religar os circuitos neurais” (o equivalente aproximado ao ajuste fino do modelo).

Dentro da estrutura MemRL

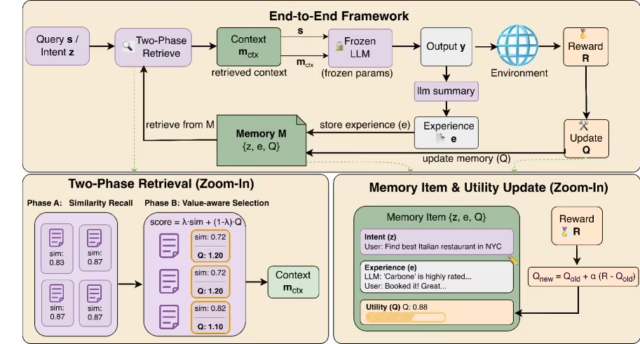

Inspirado no uso humano da memória episódica e do raciocínio cognitivo, o MemRL foi projetado para permitir que um agente melhore continuamente seu desempenho após a implantação, sem comprometer a estabilidade de seu spine LLM. Em vez de alterar os parâmetros do modelo, a estrutura muda o mecanismo de adaptação para uma estrutura de memória externa e autoevolutiva.

Nesta arquitetura, os parâmetros do LLM permanecem completamente congelados. O modelo atua efetivamente como o “córtex”, responsável pelo raciocínio geral, lógica e geração de código, mas não é responsável por armazenar sucessos ou falhas específicas encontradas após a implantação. Essa estrutura garante um raciocínio cognitivo estável e evita o esquecimento catastrófico.

Para lidar com a adaptação, o MemRL mantém um componente dinâmico de memória episódica. Em vez de armazenar documentos de texto simples e valores de incorporação estáticos, como é comum no RAG, o MemRL organiza a memória em trigêmeos “intenção-experiência-utilidade”. Eles contêm a consulta do usuário (a intenção), a trajetória específica da solução ou ação tomada (a experiência) e uma pontuação, conhecida como valor Q, que representa o sucesso dessa experiência específica no passado (a utilidade).

Crucialmente para os arquitetos empresariais, esta nova estrutura de dados não exige a eliminação da infraestrutura existente. “MemRL foi projetado para ser um substituto imediato para a camada de recuperação em pilhas de tecnologia existentes e é compatível com vários bancos de dados de vetores”, disse Muning Wen, coautor do artigo e candidato a doutorado na Shanghai Jiao Tong College, ao VentureBeat. “A existência e atualização do ‘Q-Worth’ serve apenas para melhor avaliação e gerenciamento de dados dinâmicos… e é independente do formato de armazenamento.”

Esta pontuação de utilidade é o principal diferencial dos sistemas RAG clássicos. No momento da inferência, os agentes MemRL empregam um mecanismo de “recuperação em duas fases”. Primeiro, o sistema identifica memórias que estão semanticamente próximas da consulta para garantir relevância. Em seguida, ele reclassifica esses candidatos com base em seu valor Q, priorizando efetivamente estratégias comprovadas.

A estrutura incorpora o aprendizado por reforço diretamente no processo de recuperação de memória. Quando um agente tenta uma solução e recebe suggestions ambiental (ou seja, sucesso ou falha), ele atualiza o valor Q da memória recuperada. Isso cria um ciclo fechado de suggestions: com o tempo, o agente aprende a ignorar memórias distratoras e priorizar estratégias de alto valor sem precisar treinar novamente o LLM subjacente.

Embora adicionar uma etapa de aprendizado por reforço possa parecer adicionar latência significativa, Wen observou que a sobrecarga computacional é mínima. “Nosso cálculo do valor Q é realizado inteiramente na CPU”, disse ele.

MemRL também possui recursos de aprendizagem contínua em tempo de execução. Quando o agente encontra um novo cenário, o sistema utiliza o LLM congelado para resumir a nova trajetória e adicioná-la ao banco de memória como um novo trio. Isso permite que o agente expanda sua base de conhecimento de forma dinâmica à medida que interage com o mundo.

Vale ressaltar que a automação da atribuição de valor traz um risco: se o sistema validar erroneamente uma interação ruim, o agente poderá aprender a lição errada. Wen reconhece esse risco de “memória envenenada”, mas observa que, diferentemente das redes neurais de caixa preta, o MemRL permanece transparente e auditável. “Se uma interação ruim for erroneamente classificada como um exemplo positivo… ela poderá se espalhar mais amplamente”, disse Wen. “No entanto… podemos consertar isso facilmente removendo os dados contaminados do banco de memória ou redefinindo seus valores Q.”

MemRL em ação

Os pesquisadores avaliaram o MemRL em relação a várias linhas de base em quatro benchmarks diversos do setor: BigCodeBench (geração de código), ALFWorld (navegação incorporada), Lifelong Agent Bench (sistema operacional e interação de banco de dados) e Último Exame da Humanidade (raciocínio multidisciplinar complexo).

Os resultados mostraram que o MemRL superou consistentemente as linhas de base tanto no aprendizado em tempo de execução (melhorando durante a sessão) quanto no aprendizado por transferência (generalizando para tarefas invisíveis).

As vantagens desse mecanismo de recuperação com reconhecimento de valor foram mais pronunciadas em ambientes de exploração intensa como o ALFWorld. Neste benchmark, que exige que os agentes naveguem e interajam com um ambiente doméstico simulado, o MemRL alcançou uma melhoria relativa de aproximadamente 56% em relação a MemPoutra estrutura de memória agente. Os pesquisadores descobriram que o componente de aprendizagem por reforço encorajou efetivamente o agente a explorar e descobrir soluções para tarefas complexas que os métodos de recuperação baseados em similaridade muitas vezes não conseguiam resolver.

Quando o banco de memória foi congelado e testado em conjuntos retidos para medir a generalização, o MemRL alcançou a mais alta precisão em todos os benchmarks. Por exemplo, no Lifelong Agent Bench, melhorou significativamente em relação à linha de base padrão do RAG em tarefas do sistema operacional. Isto indica que o sistema não apenas memoriza dados de treinamento, mas filtra efetivamente memórias de baixo valor para reter experiências de alta utilidade que se generalizam para novas situações.

O quadro mais amplo para agentes autoevolutivos

MemRL se enquadra em um crescente corpo de pesquisa focado em Processos de Decisão Markov Baseados em Memória (M-MDP), uma formulação que enquadra a recuperação de memória como uma etapa ativa de tomada de decisão em vez de uma função de busca passiva. Ao tratar a recuperação como uma ação que pode ser otimizada por meio de aprendizagem por reforço, estruturas como MemRL e abordagens semelhantes, como Lembrança estão abrindo caminho para sistemas mais autônomos.

Para a IA empresarial, esta mudança é significativa. Ele sugere um futuro onde os agentes podem ser implantados com um LLM de uso geral e, em seguida, adaptar-se rapidamente a fluxos de trabalho específicos da empresa, bancos de dados proprietários e conjuntos de problemas exclusivos apenas por meio da interação. A principal mudança que estamos vendo são as estruturas que tratam os aplicativos como ambientes dinâmicos com os quais eles podem aprender.

Estas capacidades emergentes permitirão que as organizações mantenham agentes consistentes e de alto desempenho que evoluem juntamente com as suas necessidades de negócio, resolvendo o problema de modelos obsoletos sem incorrer nos custos proibitivos da reciclagem constante.

Isso marca uma transição na forma como valorizamos os dados. “Em um futuro onde os dados estáticos estão prestes a se esgotar, a experiência de interação gerada por cada agente inteligente durante sua vida útil se tornará o novo combustível”, disse Wen.