Semanas depois de o X de Elon Musk ter sido inundado com imagens geradas por IA retratando pessoas, incluindo crianças, de forma sexualizada sem consentimento, a Califórnia está investigando como diabos isso aconteceu. O procurador-geral do estado, Rob Bonta anunciado Quarta-feira que ele está abrindo uma investigação sobre a situação para determinar se X e xAI, a empresa de IA de Musk e criadora do chatbot Grok que foi usado para gerar as imagens pornográficas, infringiu a lei.

“A avalanche de relatórios detalhando o materials não consensual e sexualmente explícito que a xAI produziu e publicou on-line nas últimas semanas é chocante. Este materials, que retrata mulheres e crianças em situações de nudez e sexualmente explícitas, tem sido usado para assediar pessoas em toda a Web”, disse Bonta num comunicado. Ele também instou a xAI a tomar “ações imediatas” para garantir que esse tipo de conteúdo não possa ser criado e divulgado.

Bonta parece ter bastante apoio público para a investigação. UM pesquisa recente do YouGov descobriram que 97% dos entrevistados disseram que as ferramentas de IA não deveriam ser autorizadas a gerar conteúdo sexualmente explícito de crianças, e 96% disseram que essas ferramentas não deveriam ser capazes de “despir” menores em imagens.

A investigação se concentrará na tendência que surgiu no X durante as férias de inverno, que viu os usuários solicitarem que Grok na plataforma modificasse imagens de pessoas para mostrá-las em vários estados de nudez. A tendência ficou grande o suficiente para que, de acordo com a empresa de análise de conteúdo de IA CopyleaksGrok estava gerando uma imagem sexualizada não consensual a cada minuto. Algumas dessas imagens incluíam crianças, que os usuários levaram Grok a se despir e retratar em roupas íntimas ou biquínis. Freqüentemente, os usuários solicitavam que Grok adicionasse “esmalte de donut” aos rostos dos sujeitos das imagens.

Musk – o CEO da X, a empresa onde as imagens estavam sendo compartilhadas, e da xAI, a empresa que fabrica o modelo de IA usado para gerar as imagens – optou por ofuscar ou alegar desconhecimento da situação. Em uma postagem feita antes do anúncio da investigação na Califórnia, Musk disse“Não tenho conhecimento de nenhuma imagem nua de menores de idade gerada por Grok. Literalmente zero.”

A estreiteza de sua declaração faz muito trabalho pesado, dizendo que ele não tem conhecimento de quaisquer “imagens de menores nus”. Isso não refuta a existência de imagens nuas, imagens de menores despidos ou pessoas retratadas em situações sexualizadas. Também não aborda o facto de muitas dessas imagens não serem consensuais, geradas sem a permissão da pessoa retratada. Em inúmeros casos, as imagens foram usadas diretamente para assediar contas no X.

Na medida em que Musk estava disposto a admitir que tal problema é mesmo possível, ele disse que a culpa é dos usuários, não do modelo de IA ou da plataforma que espalha o conteúdo. “Obviamente, o Grok não gera imagens espontaneamente; ele o faz apenas de acordo com as solicitações dos usuários. Quando solicitado a gerar imagens, ele se recusará a produzir qualquer coisa ilegal, pois o princípio operacional do Grok é obedecer às leis de qualquer país ou estado”, disse ele. “Pode haver momentos em que a invasão adversária dos prompts do Grok faça algo inesperado. Se isso acontecer, corrigimos o bug imediatamente.”

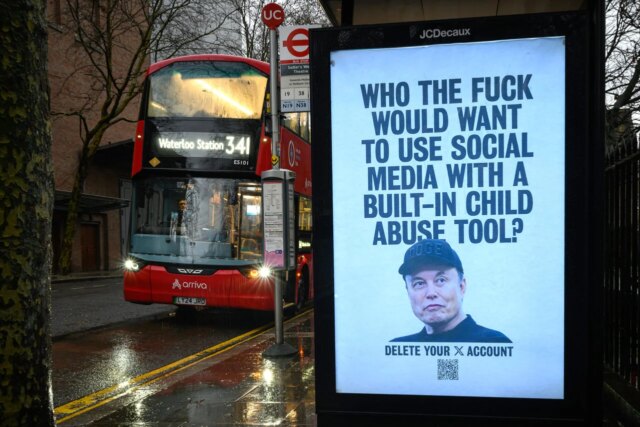

Isso está de acordo com a resposta esparsa que X ofereceu à situação. Em postagem da X Security, a empresa disse“Qualquer pessoa que use ou incentive Grok a criar conteúdo ilegal sofrerá as mesmas consequências que se carregasse conteúdo ilegal”, mas não assumiu qualquer responsabilidade por habilitá-lo. Pelo que vale, Musk também republicou zombeteiramente conteúdo criado como parte da tendência, incluindo imagens geradas por IA de uma torradeira e um foguete de biquíni.

A Califórnia é o primeiro estado do país a iniciar uma investigação sobre a situação. Autoridades de outros países, incluindo França, Irlandao Reino Unidoe Índiatodos começaram a investigar as imagens sexuais não consensuais geradas por Grok e também podem apresentar acusações contra X e xAI. A Lei Take It Down, que foi aprovada no ano passado, não exige que plataformas como X criem sistemas de notificação e remoção de imagens não consensuais até 19 de maio de 2026.