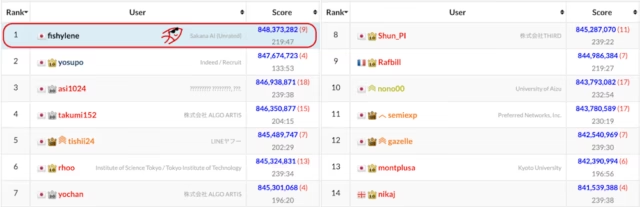

Em um feito impressionante, a startup japonesa Sakana AI’s agente de codificação ALE-Agent recentemente garantiu o primeiro lugar no AtCoder Heuristic Contest (AHC058), uma competição de codificação complexa que envolve problemas complicados de otimização – e um desafio mais difícil e talvez revelador do que benchmarks como HumanEval, que testa principalmente a capacidade de escrever funções isoladas, e que muitos modelos e agentes de IA agora passam regularmente com facilidade (“saturação de benchmark”).

Sakana a realização com o ALE-Agent sugere uma mudança em direção a agentes capazes de se otimizar de forma autônoma para navegar e ter um bom desempenho em sistemas complexos e dinâmicos, como pilhas de software program empresarial, fluxos de trabalho e ambientes operacionais.

Em quatro horas, o agente usou escala de tempo de inferência para gerar, testar e iterar centenas de soluções, resolvendo um problema que normalmente requer intuição profunda e tentativas e erros demorados de especialistas humanos. Superou mais de 800 participantes humanos, incluindo programadores competitivos de primeira linha.

Como funciona o Agente ALE

O desafio no AHC058 foi um clássico otimização combinatória problema. Os participantes foram encarregados de gerenciar um conjunto de máquinas com relacionamentos hierárquicos, como máquinas que produzem maçãs e outras máquinas que constroem essas máquinas produtoras de maçãs. O objetivo period maximizar a produção em um número fixo de voltas.

No mundo empresarial, esse fluxo de trabalho geralmente segue um padrão estrito: um especialista no domínio trabalha com um cliente para definir uma “função objetivo” (também conhecida como Pontuador) e, em seguida, os engenheiros constroem um sistema de software program para otimizá-lo. Estes problemas são notoriamente difíceis porque não podem ser resolvidos numa única etapa. Eles exigem exploração, estratégia e capacidade de articulação quando um plano não está funcionando.

Os especialistas humanos normalmente abordam isso usando uma estratégia de dois estágios. Primeiro, eles usam um método “Grasping” (um solucionador leve que faz a melhor escolha imediata em cada etapa) para gerar uma solução de linha de base decente. Então, eles aplicam “recozimento simulado“uma técnica que pega o plano existente e faz pequenos ajustes aleatórios para ver se a pontuação melhora. No entanto, essa abordagem padrão é rígida. Se o plano Grasping inicial seguir na direção errada, o recozimento simulado raramente poderá corrigi-lo porque procura apenas melhorias locais em uma área defeituosa do espaço de solução.

A inovação do ALE-Agent foi transformar esta ferramenta de inicialização estática em um mecanismo de reconstrução dinâmico. Em vez de confiar no valor imediato, o agente derivou independentemente um conceito que chamou de “Poder Digital”. Atribuiu valores a componentes que ainda não estavam operacionais, tratando-os como se já possuíssem valor. Ao avaliar potenciais activos futuros em vez de apenas os actuais, o agente capitalizou o “efeito dos juros compostos”, um conceito que identificou explicitamente no seu relatório. registros internos. Basicamente, poderia olhar alguns passos à frente e raciocinar sobre o futuro, em vez de olhar para o suggestions imediato que estava recebendo do seu ambiente.

Fundamentalmente, o agente precisava manter essa estratégia durante um período de quatro horas sem perder o foco, um modo de falha comum conhecido como “desvio de contexto”. Nos comentários fornecidos ao VentureBeat, a equipe Sakana AI explicou que o agente gera “insights” textuais ao refletir sobre cada teste. Ele reúne esse conhecimento para evitar o retorno a estratégias anteriormente fracassadas e cria uma memória de trabalho que lhe permite olhar alguns passos à frente, em vez de apenas reagir ao suggestions imediato.

Além disso, o agente integrou métodos Grasping diretamente na fase de recozimento simulada para evitar ficar preso em ótimos locais, usando reconstrução de alta velocidade para excluir e reconstruir grandes seções da solução em tempo actual.

Da codificação à otimização empresarial

Esta inovação adapta-se diretamente aos fluxos de trabalho empresariais existentes, onde uma função de pontuação já está disponível. Atualmente, as empresas contam com escassos talentos de engenharia para escrever algoritmos de otimização. O ALE-Agent demonstra um futuro onde os humanos definem o “Scorer” (isto é, a lógica de negócios e os objetivos) e o agente cuida da implementação técnica.

Isto transfere o gargalo operacional da capacidade de engenharia para a clareza das métricas. Se uma empresa puder medir uma meta, o agente poderá otimizá-la. Isto tem aplicações diretas em logística, como roteamento de veículos, bem como balanceamento de carga de servidores e alocação de recursos.

De acordo com a equipe Sakana AI, isso poderia democratizar a otimização. “Isso permite um futuro onde clientes não técnicos possam interagir diretamente com o agente, ajustando as restrições de negócios em tempo actual até obterem o resultado que desejam”, disseram.

A equipe Sakana AI disse à VentureBeat que o ALE-Agent é atualmente proprietário e não está disponível para uso público, e a empresa está atualmente focada no desenvolvimento interno e em colaborações de prova de conceito com empresas.

Ao mesmo tempo, a equipe já está pensando em “auto-reescrever” os agentes. Esses futuros agentes poderiam definir seus próprios marcadores, tornando-os viáveis para problemas mal definidos, onde os especialistas humanos lutam para formular métricas iniciais claras.

O custo da inteligência

Executar o ALE-Agent não foi barato. A operação de quatro horas incorreu em aproximadamente US$ 1.300 em custos de computação, envolvendo mais de 4.000 chamadas de raciocínio para modelos como GPT-5.2 e Gêmeos 3 Pró. Embora esse preço possa parecer alto para uma única tarefa de codificação, o retorno do investimento para problemas de otimização costuma ser assimétrico. Num ambiente de gestão de recursos, um custo único de alguns milhares de dólares pode resultar em milhões de dólares em poupanças anuais de eficiência.

No entanto, as empresas que esperam que os custos simplesmente baixem podem estar a perder a visão estratégica. Embora o custo dos tokens esteja caindo, o gasto complete pode, na verdade, aumentar à medida que as empresas competem por melhores respostas, um conceito conhecido como Paradoxo de Jevons.

“Embora algoritmos mais inteligentes impulsionem a eficiência, o principal valor da IA é a sua capacidade de explorar vastos espaços de soluções”, disse a equipe da Sakana AI. “À medida que os custos de inferência diminuem, em vez de simplesmente depositarem as poupanças, as empresas provavelmente optarão por aproveitar essa acessibilidade para realizar pesquisas ainda mais profundas e mais amplas para encontrar soluções superiores”.

O experimento destaca o imenso valor ainda a ser desbloqueado por meio de técnicas de escala de tempo de inferência. À medida que os sistemas de IA ganham a capacidade de lidar com tarefas de raciocínio complexas em contextos mais longos, a construção de melhores estruturas e a atribuição de orçamentos maiores para o “tempo de reflexão” permite que os agentes rivalizem com os melhores especialistas humanos.