A Anthropic confirmou a implementação de novas salvaguardas técnicas rigorosas que impedem que aplicativos de terceiros falsifiquem seu cliente de codificação oficial, Claude Code, a fim de acessar os modelos subjacentes de Claude AI para obter preços e limites mais favoráveis – uma medida que interrompeu os fluxos de trabalho para usuários do in style agente de codificação de código aberto OpenCode.

Simultaneamente, mas separadamente, restringiu o uso de seus modelos de IA por laboratórios rivais, incluindo xAI (através do ambiente integrado de desenvolvimento Cursor) para treinar sistemas concorrentes para o Código Claude.

A ação anterior foi esclarecida na sexta-feira por Thariq Shihipar, membro da equipe técnica da Anthropic que trabalha no Código Claude.

Escrevendo na rede social X (antigo Twitter), Shihipar afirmou que a empresa havia “reforçado nossas proteções contra a falsificação do sistema Claude Code”.

Ele reconheceu que a implementação teve danos colaterais não intencionais, observando que algumas contas de usuários foram automaticamente banidas por acionarem filtros de abuso – um erro que a empresa está atualmente revertendo.

No entanto, o bloqueio das próprias integrações de terceiros parece ser intencional.

A mudança tem como alvo aproveitamentos – wrappers de software program que controlam a conta Claude baseada na internet de um usuário by way of OAuth para conduzir fluxos de trabalho automatizados.

Isso efetivamente corta a ligação entre os planos Claude Professional/Max de taxa fixa para o consumidor e os ambientes de codificação externos.

O problema do arnês

Um chicote atua como uma ponte entre uma assinatura (projetada para bate-papo humano) e um fluxo de trabalho automatizado.

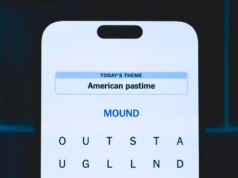

Ferramentas como o OpenCode funcionam falsificando a identidade do cliente, enviando cabeçalhos que convencem o servidor Anthropic de que a solicitação vem de sua própria ferramenta oficial de interface de linha de comando (CLI).

Shihipar citou a instabilidade técnica como o principal fator para o bloqueio, observando que os chicotes não autorizados introduzem bugs e padrões de uso que a Anthropic não consegue diagnosticar adequadamente.

Quando um wrapper de terceiros como o Cursor (em certas configurações) ou o OpenCode ocorre um erro, os usuários geralmente culpam o modelo, degradando a confiança na plataforma.

A tensão econômica: a analogia do buffet

No entanto, a comunidade de desenvolvedores apontou para uma realidade económica mais simples subjacente às restrições ao Cursor e ferramentas semelhantes: Custo.

Em extenso discussões no Hacker News começando ontem, os usuários se uniram em torno de uma analogia com o buffet: a Anthropic oferece um buffet livre por meio de sua assinatura de consumidor (US$ 200/mês para Max), mas restringe a velocidade de consumo por meio de sua ferramenta oficial, Claude Code.

Chicotes de terceiros removem esses limites de velocidade. Um agente autônomo executado dentro do OpenCode pode executar loops de alta intensidade – codificação, teste e correção de erros durante a noite – que teriam um custo proibitivo em um plano medido.

“Em um mês de Claude Code, é fácil usar tantos tokens LLM que custaria mais de US$ 1.000 se você pagasse por meio da API”, observou dfabulich, usuário do Hacker Information.

Ao bloquear essas vantagens, a Anthropic está forçando a automação de alto quantity a seguir dois caminhos sancionados:

-

A API comercial: preços medidos por token que capturam o custo actual dos loops de agente.

-

Claude Code: Ambiente gerenciado da Anthropic, onde controlam os limites de taxas e sandbox de execução.

Pivô da Comunidade: Gato e Rato

A reação dos usuários foi rápida e amplamente negativa.

“Parece muito hostil ao cliente”, escreveu o programador dinamarquês David Heinemeier Hansson (DHH), criador da in style estrutura de desenvolvimento internet de código aberto Ruby on Rails, em uma postagem no X.

No entanto, outros foram mais simpáticos à Antrópico.

“A repressão antrópica às pessoas que abusam da autenticação de assinatura é a mais gentil que poderia ter sido”, escreveu Artem Okay, também conhecido como @banteg no Xum desenvolvedor associado à Yearn Finance. “apenas uma mensagem educada em vez de destruir sua conta ou cobrar retroativamente os preços da API.”

A equipe por trás do OpenCode lançou imediatamente OpenCode Pretoum novo nível premium de US$ 200 por mês que supostamente roteia o tráfego por meio de um gateway de API empresarial para contornar as restrições de OAuth do consumidor.

Além disso, o criador do OpenCode, Dax Raad, postou no X dizendo que a empresa estaria trabalhando com a rival Anthropic OpenAI para permitir que os usuários de seu modelo de codificação e agente de desenvolvimento, Codex, “se beneficiassem de sua assinatura diretamente no OpenCode”, e então postou um GIF da cena inesquecível do filme de 2000. Gladiador mostrando Maximus (Russell Crowe) perguntando a uma multidão “Vocês não estão entretidos?” depois de cortar a cabeça de um adversário com duas espadas.

Por enquanto, a mensagem da Anthropic é clara: o ecossistema está se consolidando. Seja por meio de aplicação authorized (como visto com o uso do Cursor pela xAI) ou de salvaguardas técnicas, a period de acesso irrestrito às capacidades de raciocínio de Claude está chegando ao fim.

A situação xAI e a conexão do cursor

Simultaneamente à repressão técnica, os desenvolvedores do laboratório de IA concorrente xAI de Elon Musk teriam perdido acesso aos modelos Claude da Anthropic. Embora o momento sugira uma estratégia unificada, fontes familiarizadas com o assunto indicam que esta é uma ação de fiscalização separada baseada em termos comerciais, com o Cursor desempenhando um papel elementary na descoberta.

Conforme relatado pela primeira vez por jornalista de tecnologia Kylie Robison da publicação Memória centrala equipe do xAI tem usado modelos Anthropic – especificamente por meio do Cursor IDE – para acelerar seu próprio desenvolvimento.

“Olá equipe, acredito que muitos de vocês já descobriram que os modelos antrópicos não estão respondendo no Cursor”, escreveu o cofundador da xAI, Tony Wu, em um memorando para a equipe na quarta-feira, de acordo com Robison. “De acordo com o Cursor, esta é uma nova política que a Antrópica está aplicando a todos os seus principais concorrentes.”

No entanto, a Secção D.4 (Restrições de Utilização) do Termos de Serviço Comercial da Anthropic proíbe expressamente os clientes de usar os serviços para:

(a) acessar os Serviços para construir um produto ou serviço concorrente, inclusive para treinar modelos de IA concorrentes… [or] (b) fazer engenharia reversa ou duplicar os Serviços.

Neste caso, o Cursor serviu como veículo para a violação. Embora o IDE em si seja uma ferramenta legítima, o uso específico dele pela xAI para alavancar Claude para pesquisas competitivas desencadeou o bloqueio authorized.

Precedente para o bloco: os pontos de corte OpenAI e Windsurf

A restrição ao xAI não é a primeira vez que a Anthropic usa seus Termos de Serviço ou controle de infraestrutura para isolar um grande concorrente ou ferramenta de terceiros. As ações desta semana seguem um padrão claro estabelecido ao longo de 2025, onde a Antrópica agiu agressivamente para proteger sua propriedade intelectual e recursos computacionais.

Em agosto de 2025, a empresa revogou o acesso da OpenAI à API Claudeem circunstâncias surpreendentemente semelhantes. Fontes contadas Com fio que a OpenAI estava usando Claude para avaliar seus próprios modelos e testar respostas de segurança – uma prática sinalizada pela Antrópica como uma violação de suas restrições competitivas.

“Claude Code se tornou a escolha certa para programadores em todos os lugares e, portanto, não foi nenhuma surpresa saber que a própria equipe técnica da OpenAI também estava usando nossas ferramentas de codificação”, disse um porta-voz da Anthropic na época.

Poucos meses antes, em junho de 2025, o ambiente de codificação Windsurf enfrentou um apagão repentino semelhante. Em um declaração públicaa equipe do Windsurf revelou que “com menos de uma semana de antecedência, a Anthropic nos informou que estava cortando quase toda a nossa capacidade primária” para a família de modelos Claude 3.x.

A mudança forçou o Windsurf a retirar imediatamente o acesso direto para usuários gratuitos e adotar um modelo “Traga sua própria chave” (BYOK), ao mesmo tempo em que promovia o Gemini do Google como uma alternativa estável.

Embora o Windsurf tenha eventualmente restaurado o acesso primário para usuários pagos semanas depois, o incidente – combinado com a revogação do OpenAI e agora o bloqueio xAI – reforça um limite rígido na corrida armamentista de IA: embora laboratórios e ferramentas possam coexistir, a Anthropic se reserva o direito de cortar a conexão no momento em que o uso ameaça sua vantagem competitiva ou modelo de negócios.

O Catalisador: A Ascensão Viral do ‘Código Claude’

O momento de ambas as repressões está inextricavelmente ligado ao enorme aumento na popularidade do Claude Code, o ambiente terminal nativo da Antrópico.

Embora o Claude Code tenha sido lançado originalmente no início de 2025, ele passou grande parte do ano como um utilitário de nicho. O verdadeiro momento de ruptura chegou apenas em dezembro de 2025 e nos primeiros dias de janeiro de 2026 – impulsionado menos por atualizações oficiais e mais pelo fenômeno “Ralph Wiggum” liderado pela comunidade.

Nomeado em homenagem ao estúpido Simpsons personagem, o plugin Ralph Wiggum popularizou um método de codificação de “força bruta”. Ao prender Claude em um loop de autocura onde as falhas são realimentadas na janela de contexto até que o código passe nos testes, os desenvolvedores alcançaram resultados surpreendentemente próximos do AGI.

Mas a controvérsia atual não é sobre a perda de acesso dos usuários à interface do Claude Code – que muitos usuários avançados consideram limitante – mas sim sobre o mecanismo subjacente, o modelo Claude Opus 4.5.

Ao falsificar o cliente oficial do Claude Code, ferramentas como o OpenCode permitiram que os desenvolvedores aproveitassem o modelo de raciocínio mais poderoso da Anthropic para loops complexos e autônomos a uma taxa de assinatura fixa, arbitrando efetivamente a diferença entre preços ao consumidor e inteligência de nível empresarial.

Na verdade, como escreveu o desenvolvedor Ed Andersen no X, parte da popularidade do Claude Code pode ter sido impulsionada por pessoas que o falsificaram dessa maneira.

Claramente, os usuários avançados queriam executá-lo em grandes escalas sem pagar taxas corporativas. As novas ações de fiscalização da Antrópico são uma tentativa direta de canalizar esta demanda desenfreada de volta aos seus canais sancionados e sustentáveis.

Conclusões do desenvolvedor empresarial

Para engenheiros seniores de IA focados em orquestração e escalabilidade, essa mudança exige uma rearquitetura imediata de pipelines para priorizar a estabilidade em vez da economia de custos brutos.

Embora ferramentas como o OpenCode oferecessem uma alternativa atraente e de taxa fixa para automação pesada, a repressão da Anthropic revela que esses wrappers não autorizados introduzem bugs e instabilidade não diagnosticáveis.

Garantir a integridade do modelo agora requer o roteamento de todos os agentes automatizados por meio da API comercial oficial ou do cliente Claude Code.

Portanto, os tomadores de decisão empresariais devem tomar nota: embora as soluções de código aberto possam ser mais acessíveis e mais tentadoras, se estiverem sendo usadas para acessar modelos proprietários de IA como os da Anthropic, o acesso nem sempre é garantido.

Essa transição exige uma nova previsão dos orçamentos operacionais – passando de assinaturas mensais previsíveis para faturamento variável por token – mas, em última análise, troca a previsibilidade financeira pela garantia de um ambiente compatível e pronto para produção.

Do ponto de vista de segurança e conformidade, os bloqueios simultâneos em xAI e ferramentas de código aberto expõem a vulnerabilidade crítica da “Shadow AI”.

Quando as equipes de engenharia usam contas pessoais ou tokens falsificados para contornar os controles corporativos, elas correm o risco não apenas de dívida técnica, mas também de perda repentina de acesso em toda a organização.

Os diretores de segurança devem agora auditar cadeias de ferramentas internas para garantir que nenhum “dogfooding” de modelos concorrentes viole os termos comerciais e que todos os fluxos de trabalho automatizados sejam autenticados por meio de chaves corporativas adequadas.

Neste novo cenário, a fiabilidade da API oficial deve superar a poupança de custos de ferramentas não autorizadas, uma vez que o risco operacional de uma proibição whole supera em muito os custos de uma integração adequada.